Avec le développement rapide des applications de l’intelligence artificielle, mais aussi de l’IoT ou du Machine Learning, la densité thermique des équipements informatiques des datacenters augmente rapidement. Cette augmentation va nécessiter de nouvelles solutions de refroidissement de ces équipements. Le refroidissement liquide (Liquid Cooling) se développe avec différentes technologies pour remplacer le refroidissement par air pour ces nouvelles applications et pourrait devenir indispensable.

En quelques années, le développement de l’intelligence artificielle (IA) a gagné tous les secteurs de l’industrie, de la santé, de la finance, mais aussi la vie courante. Cette IA, mais aussi le développement de l’IoT, de la 5G industrielle ou du calcul haute performance (HPC) sont à l’origine de nouvelles technologies de microprocesseurs ou de serveurs de plus en plus nombreux et gourmands en énergie.

Comme le souligne Pankaj Sharma, vice-président exécutif Secure Power Division and Data Centers Business de Schneider Electric, « alors que l’IA ne cesse de progresser, elle impose des exigences uniques à la conception et à la gestion des datacenters. Pour relever ces défis, il est important de prendre en compte plusieurs attributs et tendances clés des charges de travail relatives à l’IA qui ont un impact sur les datacenters actuels et futurs. Les applications d’IA, en particulier les pôles d’entraînement, nécessitent des calculs intensifs et de grandes quantités de puissance de traitement fournies par les GPU ou les accélérateurs d’IA spécialisés. Cela met à rude épreuve les infrastructures d’alimentation et de refroidissement des datacenters. Et comme les coûts de l’énergie augmentent au même titre que les préoccupations environnementales, les datacenters doivent privilégier un matériel économe en énergie, comme les systèmes d’alimentation et de refroidissement à haut rendement, et des sources d’énergie renouvelables pour aider à réduire les coûts d’exploitation et l’empreinte carbone ».

En 2023 d’après les estimations de Schneider Electric, l’IA a représenté 8 % de la charge de travail des datacenters et devrait passer à 15-20 % en 2028, comme le confirme François Salomon, directeur Activité Froid & Climatisation Secure Power Division de Schneider Electric France. « Nous estimons que la croissance des applications de type IA dans les datacenters va croître de 26 à 36 % pour an, soit deux fois plus vite que la croissance estimée sur le datacenter standard. Cette croissance va concerner le monde entier, mais sera probablement plus rapide aux États-Unis au départ, avant de se développer à l’échelle industrielle en Europe, donc en France. L’IA sera portée dans un premier temps par les grands acteurs du cloud et de l’hébergement qui développent d’ores et déjà des infrastructures permettant d’accueillir ce type d’application très spécifique du fait de leurs densités, impliquant des puissances électriques très soutenues et des solutions de refroidissement à cœur à base de liquide (Liquid Cooling). »

Des changements dans la conception et l’exploitation des centres de données

Le développement rapide de ces nouvelles applications va avoir un impact lourd sur l’infrastructure physique des centres de données avec le besoin de plus de surface, sur leur alimentation électrique, sur la gestion des racks et des baies et sur leur refroidissement.

Dans ces datacenters, les installations hébergeant majoritairement des CPU (Central Processing Unit) doivent faire une place de plus en plus importante aux GPU (Graphic Processing Unit). Ces GPU, développés par Nvidia dès 1999, et d’abord utilisés pour l’animation 3D ou les jeux vidéo, sont aujourd’hui mis à contribution pour l’apprentissage automatique (Machine Learning), le minage de cryptomonnaies ou l’IA. Cette montée en puissance de l’IA augmente les besoins en puissance de calcul des datacenters pour l’entraînement de l’IA avec une infrastructure disposant d’une puissance de calcul élevée et l’inférence qui nécessite une infrastructure à rendement élevé et une faible latence.

Les tendances actuelles vont vers une augmentation continue de la puissance des GPU pour réaliser des tâches de plus en plus complexes comme l’annoncent les nouvelles séries Blackwell de Nvidia ou Gaudi 3 d’Intel.

Ces GPU sont conçus pour avoir des températures de fonctionnement qui peuvent dépasser 80 °C.

Avec de telles augmentations, la question du refroidissement, mais aussi de l’optimisation de l’énergie, se pose rapidement tout en pensant à l’avenir des datacenters pour accompagner cette montée en puissance qui devrait continuer.

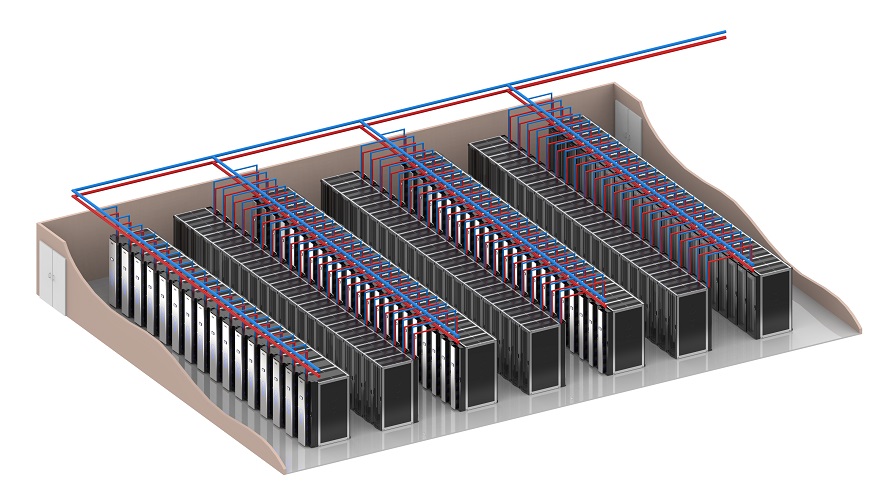

Séverine Hanauer, directrice Segments Stratégiques Telco & Déploiement Edge, Europe du Sud chez Vertiv, confirme que ces nouveaux usages numériques engendrent une forte croissance de la consommation électrique des datacenters. « Cela est principalement dû à l’adoption croissante des technologies et applications de calcul accéléré, comme l’intelligence artificielle (IA), l’informatique haute performance (HPC), l’apprentissage automatique, etc., qui augmentent la capacité de traitement. Elles exigent une demande de puissance de calcul élevée de l’infrastructure des datacenters entraînant de plus hautes densités thermiques par puce, au niveau des serveurs, des racks, de la consommation d’énergie et des niveaux de chaleur qu’il faut nécessairement évacuer. Dans certaines applications, la chaleur produite atteint un niveau où le refroidissement à air ne suffit pas pour gérer efficacement la température dans les racks à très haute densité. [Photo 4 Vertiv]

Les densités de racks augmentent dans les datacenters stimulés par les dernières puces x86 et les puces de traitement graphique (GPU) compatibles avec l’IA, dépassant la puissance thermique de conception (TDP) de 300 watts (W) et 800 W respectivement, et approchant rapidement les 1 000 W ou plus. Avec cette tendance, les serveurs d’IA les plus récents se rapprochent d’un TDP de 6 kW à 10 kW par serveur. Ces puces d’IA peuvent nécessiter environ cinq fois plus d’énergie et cinq fois plus de capacité de refroidissement dans le même espace qu’un serveur traditionnel. Les densités de racks de 40 kW par rack sont aujourd’hui au bas de l’échelle de ce qui est nécessaire pour faciliter les déploiements d’IA. Les densités de racks dépassant 100 kW par rack deviennent courantes et à plus grande échelle dans un avenir proche. Cela nécessitera d’importantes augmentations de capacité sur l’ensemble de la chaîne d’alimentation, depuis le réseau jusqu’aux puces dans chaque rack. »

Les exploitants de datacenters doivent donc faire rapidement des choix techniques pour répondre à cette évolution qui devrait encore s’accélérer.

Scott Bailey, CEO de Legrand/USystems, a constaté un changement majeur dans les exigences des utilisateurs finaux et de ses partenaires de distribution non seulement pour la technologie de l’IA, mais aussi pour les solutions de calcul haute performance existantes où l’utilisateur final met à niveau ses serveurs et ses solutions de puces. « Nous avons vu au cours des 10 à 15 dernières années une demande moyenne de 4 à 10 kW par armoire et, grâce aux nouvelles technologies et à l’augmentation de la capacité des puces et de la consommation de serveurs, cela a conduit la demande à une moyenne de 30 à 100 kW + par armoire. De plus, de nombreux fournisseurs de centres de données cherchent à moderniser leurs centres de données pour gérer la demande de leurs utilisateurs finaux. Parmi les applications qui nécessitent le calcul de l’IA, citons l’apprentissage de grandes langues, le minage de cryptomonnaies et les solutions automobiles, pour n’en citer que quelques-unes.

L’IA et le calcul haute performance entraînent donc de profonds changements dans les exigences des centres de données, principalement en raison de la densité et de la consommation d’énergie intenses des éléments de calcul modernes tels que les GPU et les processeurs spécialisés. Ces technologies nécessitent non seulement plus d’énergie, mais génèrent également une chaleur importante, repoussant les limites des méthodes traditionnelles de refroidissement et de distribution d’énergie. »

Le refroidissement à air atteint ses limites avec ces consommations d’énergie en forte augmentation dans les baies

Le refroidissement à air a fait de gros progrès ces dernières années pour augmenter son efficacité en réduisant sa consommation d’énergie, mais aussi d’eau. Le free cooling ou les allées froides/allées chaudes ont permis de réduire le PUE, mais l’énergie consommée par les systèmes de refroidissement reste le plus gros poste de coût de fonctionnement d’un datacenter.

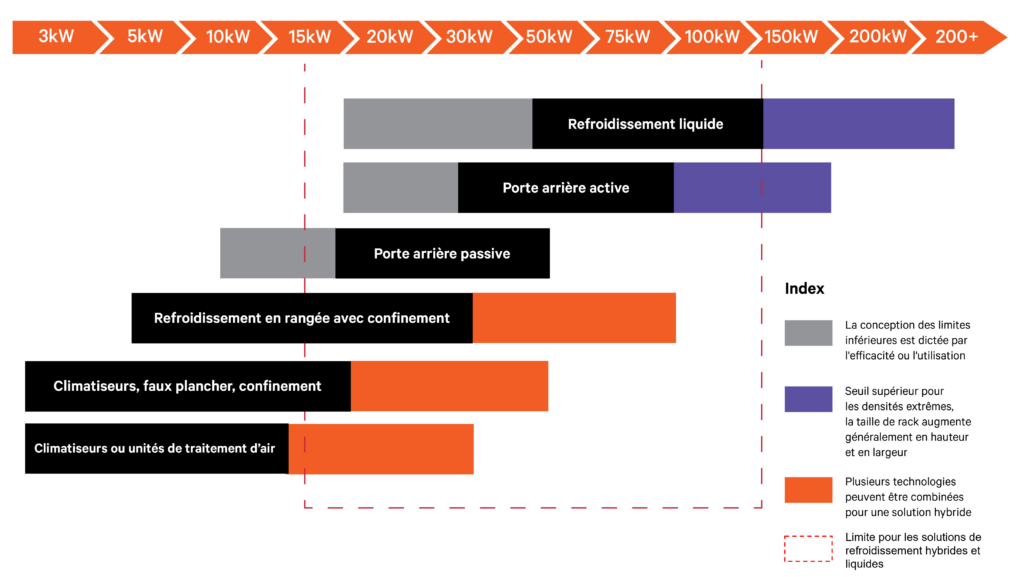

Comme le note François Salomon, d’un point de vue théorique l’air permet de traiter n’importe quelle charge. « Mais dans la pratique, refroidir des racks informatiques travaillant à haute densité à l’air est impossible dans les infrastructures IT car cela impliquerait de brasser chaque rack avec plusieurs milliers de mètres cubes d’air par heure, ce que ne permettent pas les installations ni l’encombrement des racks, l’air étant, in fine, un caloporteur plutôt médiocre.

Dans les faits, il est possible de refroidir des racks informatiques à l’air jusqu’à une densité de 30 kW maximale de la baie avec des refroidisseurs de type InRow – seul équipement qui permet de garantir une homogénéité de diffusion d’air sur toute la hauteur du rack. Au-delà de cette densité, il faut passer sur un caloporteur liquide, plus performant, et plus à même de récupérer les calories diffusées par le serveur haute densité.

Le free cooling peut, quant à lui, être déployé sur les architectures à air comme sur les architectures liquid cooling. Il sera néanmoins encore plus performant sur les architectures en liquid cooling car en densifiant la charge thermique et en utilisant un caloporteur liquide plus performant, nous allons pouvoir travailler sur des régimes de température toujours plus élevés, et donc renforcer le fonctionnement en free cooling déjà très largement utilisé dans le climat tempéré français. »

« Par conséquent, de nombreux datacenters établissent des stratégies pour la mise en œuvre de solutions de refroidissement prêtes pour l’avenir et adaptées à l’évolution des besoins de l’entreprise, explique Séverine Hanauer. Les équipes informatiques et les installations doivent décider de l’espace à allouer aux nouvelles charges de travail d’IA/HPC pour soutenir la demande actuelle et la croissance au cours des deux prochaines années. Certaines convertiront quelques racks à la fois, tandis que d’autres affecteront des salles entières à ces nouvelles technologies et prendront en charge l’ajout de systèmes de refroidissement liquide en plus du refroidissement par air.

En réalisant de plus en plus de traitements de données sur la même période, la densité calorifique à l’intérieur d’une baie informatique ne cesse d’augmenter. C’est la raison pour laquelle de nombreux efforts sont réalisés au niveau de l’urbanisation des salles. Ainsi, les baies serveurs sont positionnées de manière à optimiser la gestion des flux d’air chaud/froid. Tout est cloisonné en allées froides ou chaudes. Les opérateurs de datacenters, mais aussi les entreprises qui possèdent leurs propres installations, intègrent également des systèmes de refroidissement pour gérer de manière optimale la dissipation de chaleur des équipements informatiques.

Mais le plus important est d’intégrer la technologie de refroidissement la mieux adaptée à l’application et à la configuration physique du site. Parmi les dernières tendances, on trouve différentes solutions et notamment des systèmes à base d’eau glacée qui se présentent sous forme de murs de refroidissement pour mieux canaliser les flux d’air et refroidir au plus près des équipements informatiques. L’objectif est également de limiter la démultiplication d’équipements de refroidissement traditionnels dans ou à l’extérieur d’une salle informatique.

L’avenir des solutions de refroidissement est là et l’adoption des stratégies de refroidissement hybride combinant l’air et le liquide dans les datacenters s’amorce. Avec l’augmentation de la densité informatique, le développement des services cloud, l’utilisation de l’IA pour renforcer l’analytique avancée et la prise de décision automatisée, sans oublier les préoccupations croissantes en matière de développement durable, l’industrie des datacenters s’attend à un intérêt croissant pour le déploiement de la technologie de refroidissement liquide dans les années à venir.

Dans les cas de densité calorifique extrême, le refroidissement liquide est la solution nécessaire pour évacuer efficacement la chaleur, grâce aux propriétés de transfert thermique des liquides. Les opérateurs de datacenter étudient de plus en plus les options de refroidissement liquide, à mesure que le nombre d’applications informatiques à traitement intensif augmente. Et de nombreux datacenters étudient la possibilité d’introduire des systèmes de refroidissement hybride, associant refroidissement à air et liquide. D’autant que les choix retenus en matière de refroidissement liquide vont grandement influencer les besoins en nouvelles installations, compétences et méthodes de travail.

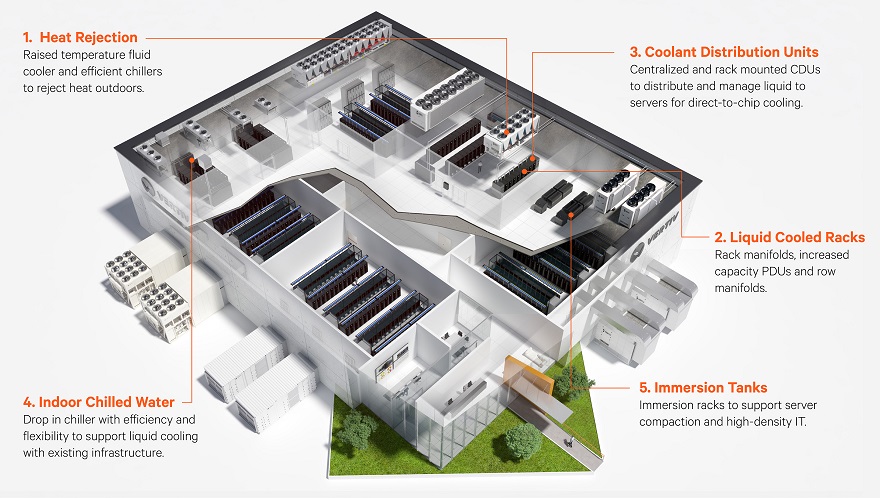

Pour simplifier la transition vers la haute densité, Vertiv a introduit une gamme de solutions optimisées comprenant des technologies d’alimentation et de refroidissement capables de supporter des charges de travail allant jusqu’à 100 kW par rack dans un ensemble varié de configurations de déploiement, par exemple le Vertiv Liebert HPC-S, groupe de production d’eau glacée avec faible impact environnemental.

Ces conceptions offrent aux intégrateurs système, aux fournisseurs de colocation, aux fournisseurs de services cloud ou aux utilisateurs d’entreprise de multiples possibilités de créer dès maintenant le datacenter du futur. Chaque installation spécifique peut présenter des nuances quant au nombre et à la densité des racks, dictées par la sélection des équipements informatiques. Ainsi, cette série de conceptions offre un moyen intuitif de se limiter définitivement à une conception de base et de l’adapter exactement aux besoins de déploiement. »

Introduire des conceptions de datacenters optimisés pour l’IA

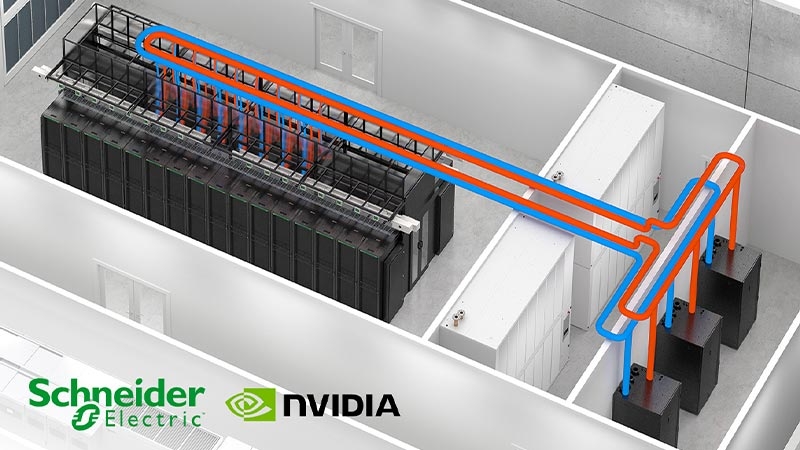

Lors de son Innovation Summit 2024 à Paris début avril, Schneider Electric a annoncé sa collaboration avec Nvidia afin d’optimiser l’infrastructure des datacenters et d’ouvrir la voie à des avancées révolutionnaires dans le domaine des technologies d’intelligence artificielle (IA) et de jumeaux numériques.

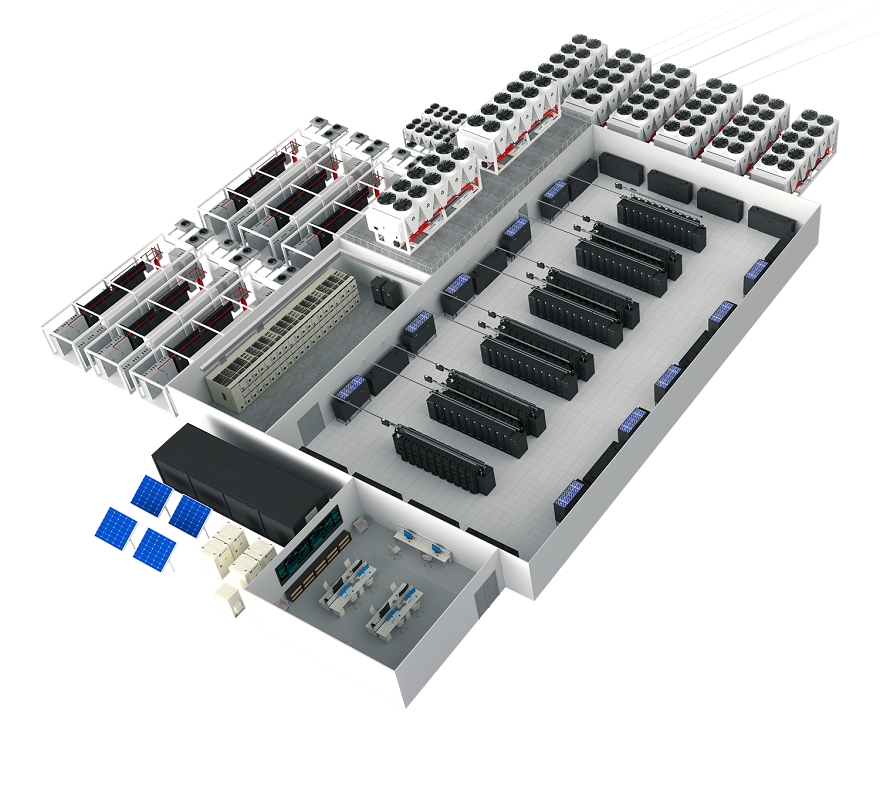

Schneider Electric s’appuiera sur son expertise en matière d’infrastructures de datacenters et sur les technologies d’IA avancées de Nvidia pour présenter les premiers « Reference Designs » de datacenters optimisés pour l’IA. Ces designs seront une référence pour le déploiement et l’exploitation de l’IA dans les écosystèmes des centres de données, marquant ainsi une étape importante dans l’évolution de ce secteur.

Les applications d’IA s’imposent partout, exigeant davantage de ressources que l’informatique traditionnelle, si bien que les besoins en puissance de traitement ont augmenté de manière exponentielle. L’essor de l’IA a entraîné des transformations notables et de la complexité dans la conception et l’exploitation des datacenters. Pour répondre à ce développement, les opérateurs de ces centres s’efforcent de construire et d’exploiter rapidement des installations stables sur le plan énergétique, à la fois économes en énergie et évolutives.

Comme le souligne Marc Garner, senior vice-président Secure Power Division Europe de Schneider Electric, « le déploiement de l’IA apporte ses propres défis au marché des datacenters en termes de besoin d’énergie, de disponibilité d’espace, d’augmentation des coûts et des tarifs de location et d’augmentation de la taille des hyperscalers ».

Pendant la première phase de cette collaboration, Schneider Electric présentera des Reference Designs de datacenters de pointe conçus sur mesure pour les clusters de calcul accéléré de Nvidia et destinés au traitement des données, à la simulation d’ingénierie, à l’automatisation de la conception électronique, à la conception de médicaments assistée par ordinateur et à l’IA générative. Une attention particulière sera accordée à la distribution de haute puissance, aux systèmes de refroidissement par liquide et aux contrôles conçus pour assurer une mise en service simple et des opérations fiables pour les clusters à densité extrême. En répondant aux exigences spécifiques des charges de travail relatives à l’IA, les Reference Designs apporteront un cadre solide pour implanter la plateforme de calcul accéléré de Nvidia dans les centres de données.

En plus des Reference Designs de datacenters, AVEVA, filiale de Schneider Electric, connectera sa plateforme de jumeaux numériques à Nvidia Omniverse, fournissant un environnement unifié pour les simulations virtuelles et la collaboration. Cette intégration permettra une collaboration fluide entre les ingénieurs et les parties prenantes, accélérant ainsi la conception et le déploiement de systèmes complexes, tout en aidant à réduire les délais de mise sur le marché et les coûts.

Dion Harris, Director Accelerated Data Centers GTM de Nvidia, a également annoncé la prochaine génération de GPU, Blackwell, qui permettra aux utilisateurs de créer et d’exécuter une IA générative en temps réel sur de grands modèles de langage, avec un coût et une consommation d’énergie 25 fois inférieurs à ceux de son prédécesseur, la série Hopper. Ce GPU compte 208 milliards de transistors, à comparer aux 80 milliards de Hopper. Blackwell va rendre l’IA plus performante et nécessitera de revoir l’architecture du datacenter, en particulier pour son refroidissement.

Plusieurs techniques de refroidissement liquide se développent pour répondre à ces nouveaux besoins

Le refroidissement liquide des ordinateurs n’est pas nouveau, puisqu’il a été utilisé dès les années 1960 par IBM pour ses ordinateurs d’entreprises, mais de nouvelles technologies se développent à l’échelle du datacenter avec des techniques qui peuvent être 50 à 1000 fois plus efficaces que le refroidissement par air.

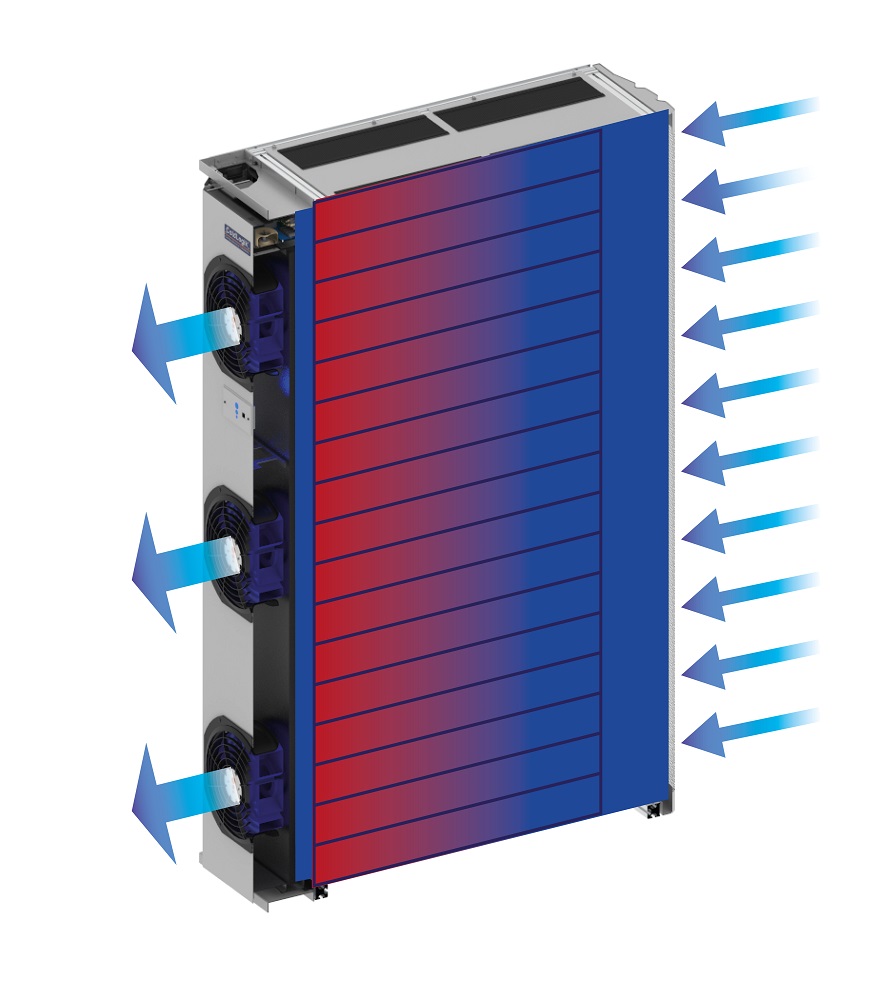

Trois principales techniques sont aujourd’hui mises en œuvre, utilisant ce refroidissement liquide avec des solutions très différentes : le refroidissement par immersion (Immersion Cooling), le refroidissement direct sur puce (Direct-to-Chip) et le refroidissement par échange thermique de la porte arrière (Rear Door Coolers-RDC ou Rear Door Heat Exchangers).

« Le principe de l’Immersion Cooling est d’immerger totalement le serveur dans un bain composé d’une huile diélectrique qui circule et assure le refroidissement de ce dernier, explique François Salomon. Le fluide peut être monophasique ou biphasique (il passe alors à l’état gazeux en absorbant les calories issues des serveurs). L’immersion peut se faire soit dans un bac qui accueille de multiples serveurs, soit individuellement au niveau de chaque serveur (châssis immersif).

Le principe du Direct-to-Chip est de refroidir les éléments les plus consommateurs des serveurs, donc les CPU/GPU, au travers de petits échangeurs appelés Cold Plate qui viennent s’apposer directement sur les composants dans les serveurs. Le serveur n’est donc pas immergé. Ce sont des échangeurs irrigués en liquide qui viennent récupérer les calories des composants les plus consommateurs du serveur. »

Pour Scott Bailey, CEO de USystems, la solution de porte arrière est un moyen très efficace et rapide d’avoir une véritable flexibilité sur la croissance de la demande pour les entreprises de centres de données. « Au fur et à mesure que nous constatons l’augmentation de la puissance et du refroidissement avec divers modèles d’IA et fabricants de puces, vous verrez diverses solutions de refroidissement hybrides. Une solution hybride typique que nous voyons actuellement sur le marché est une solution de refroidissement direct à la puce avec un modèle de porte arrière pour permettre une véritable croissance flexible et évolutive. Les solutions de refroidissement de la porte arrière de ColdLogik/USystems rapprochent considérablement le refroidissement de l’armoire, offrant des avantages significatifs en termes de performances par rapport aux unités CRAC. De plus, ces unités CRAC occupant jusqu’à un tiers de l’espace d’une salle de données, la technologie de la porte arrière permet de récupérer cet espace. Pour un datacenter, où chaque armoire peut lui rapporter 20 000 € par an, le retour sur investissement de l’installation de la solution de refroidissement de la porte arrière est extrêmement intéressant. »

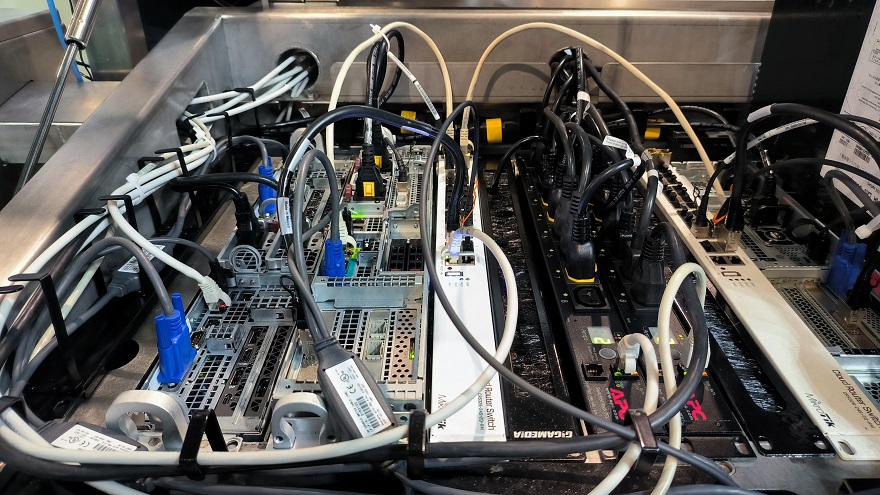

L’Immersion Cooling nécessite une adaptation des datacenters

Ce refroidissement liquide utilise un fluide diélectrique (non conducteur) dans lequel sont totalement ou partiellement immergés les serveurs montés verticalement avec un refroidissement par conduction ou pompage ; les échangeurs et les pompes pouvant se trouver à l’intérieur du bac ou à l’extérieur. Le liquide de refroidissement peut être monophasé ou biphasé. Dans ce deuxième cas, le fluide diélectrique passe de l’état liquide à l’état gazeux quand il se réchauffe, avant de repasser à l’état liquide par condensation sur un serpentin.

Cette solution, pour François Salomon, présente l’avantage d’être packagée et simple à déployer : « La quasi-totalité de la charge thermique est absorbée par la solution Liquid Cooling, il n’y a donc presque aucune charge thermique résiduelle sur l’air à traiter. La performance énergétique est donc optimale. Sa mise en œuvre et son intégration sont cependant plus complexes dans les salles IT actuelles : le poids du bac, la nécessité de palans pour manipuler les serveurs, la mise en place de bac de rétention en font une application très spécifique qui nécessite de revoir complètement les méthodes d’exploitation des salles. Certains doutent également de la possibilité de refroidir des serveurs de très haute densité (>100 kW/rack) : l’immersion totale du serveur et l’homogénéité de la solution pourraient favoriser l’apparition de points chauds sur les GPU les plus consommateurs ».

Selon Séverine Hanauer, « le refroidissement liquide, par immersion (Immersion Cooling), nécessite un réagencement du datacenter. En effet, l’organisation standard en baies verticales est remplacée par des réservoirs horizontaux dans lesquels les équipements IT sont intégralement immergés dans un fluide diélectrique thermoconducteur. Le refroidissement par immersion est une technologie prometteuse, mais pas encore complètement mature, car elle nécessite aussi le développement des compétences des exploitants de datacenters pour être tout à fait opérationnelle sur ces nouvelles solutions, leurs enjeux et leurs contraintes ».

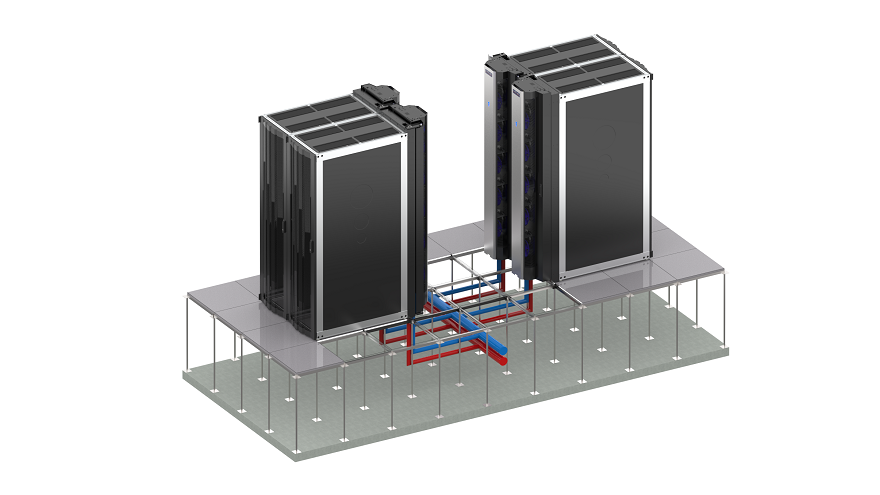

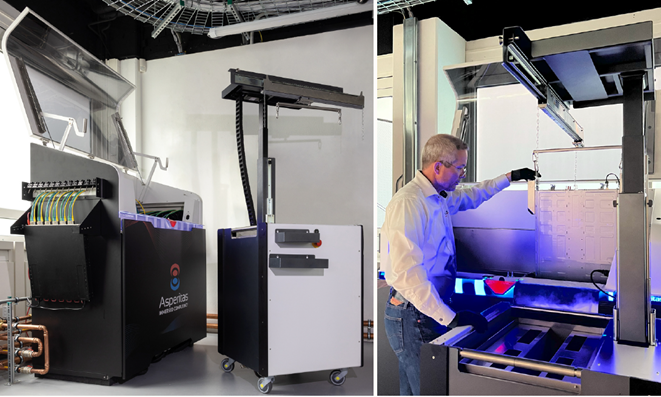

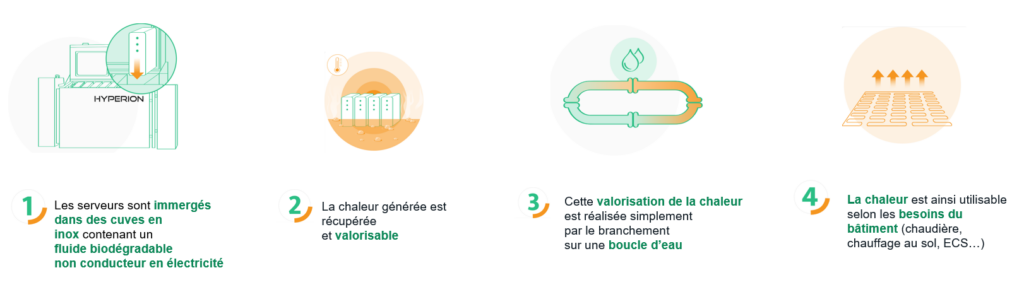

Le Groupe Numains, basé à Laval, a développé sa solution Hyperion de refroidissement par immersion destinée au stockage de données et au calcul. Ce sont des serveurs configurés pour être immergés dans un fluide caloporteur 100 % biodégradable pour un service cloud ou de datacenter. Hyperion peut être installé chez les clients ou pour des machines virtuelles (VM) dans les datacenters du Groupe Numains. Hyperion permet la récupération de 90 % de l’énergie générée par les serveurs et d’atteindre un PUE de 1,1 avec une économie circulaire avec la gestion du bâtiment.

« Hyperion est une solution d’hébergement de données pour datacenter qui a été conçue pour concilier des performances maximales avec un impact énergétique et environnemental optimisé, explique Xavier Colas, directeur Innovations & Projets stratégiques de Numains. Notre solution se passe de climatisation et peut être installée dans tout type de local, dans un bâtiment tertiaire comme sur un site industriel, sans avoir recours à une salle blanche. Hyperion permet de diviser quasiment par deux la consommation électrique et de valoriser l’énergie fatale produite par l’usage informatique.

Plusieurs projets de déploiement sont en cours, dans les datacenters, en entreprise, dans les collectivités, en France et à l’étranger dans un contexte de besoins importants. C’est particulièrement vrai dans les pays chauds où les enjeux sont de taille. Il est en effet aberrant de climatiser une salle à moins de 20 °C quand il fait plus de 35 °C à l’extérieur, tant sur le plan environnemental qu’énergétique.

Nous l’utilisons dans nos infrastructures d’hébergement depuis plus de 2 ans, avec plus de 70 VM (serveurs virtuels) pour nos clients hébergés. »

La solution Direct-to Chip permet de conserver une urbanisation proche des salles actuelles

Cette solution de refroidissement nécessite d’amener le liquide de refroidissement directement aux composants les plus chauds des serveurs, les CPU ou GPU, sur une plaque froide placée sur la puce.

Son avantage pour François Salomon est de conserver une urbanisation informatique identique ou très proche des salles actuelles. « Le mode d’exploitation des serveurs sera également sensiblement équivalent à celui des datahalls existants. La technologie permet par ailleurs de faire cohabiter des salles mixtes, comprenant des serveurs refroidis à l’air et des serveurs refroidis à l’eau. La disponibilité du fluide qui refroidit les serveurs (en général de l’eau avec 25 % de monopropylène glycol) est un atout. Enfin, le refroidissement à cœur via les Cold Plates permettrait de refroidir n’importe quelle GPU, y compris en très haute densité (750W et au-delà). L’inconvénient de la solution est la charge thermique résiduelle de l’air, comprise en général entre 5 % et 20 % de la charge IT totale, et qui implique de maintenir une solution de refroidissement traditionnelle à l’air en plus des solutions Liquid Cooling. De ce fait, la performance énergétique globale de ces infrastructures sera très légèrement inférieure à celle des infrastructures en immersif ».

Pour Séverine Hanauer le système de refroidissement liquide Direct-to-Chip est le plus proche de ce que nous connaissons avec une baie informatique standard. « La différence réside dans une conception de la baie qui doit intégrer un collecteur de liquide pour le distribuer à l’équipement informatique, lui-même nécessairement compatible Direct-to-Chip (ITE). Pour cette solution, Vertiv a développé le Liebert® XDU, un système installé entre la production de froid et les équipements informatiques pour assurer une parfaite distribution. Dans ce cas, il est essentiel de modifier l’espace technique du site, ce qui nécessite une planification spécifique.

Dans ce cas, et grâce aux propriétés de transfert thermique des liquides, bien plus importantes que celles de l’air, le refroidissement liquide est la seule option pour évacuer efficacement la chaleur, via des méthodes telles que le refroidissement Direct-to-Chip (D2C) ou par immersion.

De fait, la température du fluide peut être élevée pour maintenir les conditions de fonctionnement du système informatique, sans augmenter la puissance de ventilation, car le refroidissement est dirigé vers les composants les plus chauds, généralement le processeur. Le transfert de chaleur entre le processeur et sa plaque froide est donc beaucoup plus efficace que le transfert de chaleur entre le processeur et l’air environnant pour un système de refroidissement à air traditionnel, ce qui favorise l’efficacité globale du datacenter.

En parallèle, la température de retour d’eau dans les racks, qui est élevée par rapport au refroidissement à air traditionnel, peut permettre de récupérer cette chaleur pour d’autres usages (chauffage, par exemple), ce qui n’est pas possible (ou moins efficace) avec un datacenter refroidi par air. »

La solution des échangeurs de porte arrière (RDHx)

Les échangeurs de chaleur de porte arrière (RDHx), également connus sous le nom de refroidisseurs de porte arrière (RDC), sont une technologie de refroidissement liquide éprouvée, parfois connue sous le nom de refroidissement liquide assisté par air, qui est conçue pour fonctionner comme un système en boucle fermée.

L’air ambiant est aspiré dans le rack par les ventilateurs de l’équipement informatique. L’air chaud évacué est expulsé de l’équipement et aspiré sur l’échangeur de chaleur assisté par des ventilateurs EC montés dans le châssis RDC. L’air évacué transfère la chaleur dans le liquide de refroidissement à l’intérieur de l’échangeur de chaleur, et l’air nouvellement refroidi est expulsé dans la pièce à la température ambiante prédéterminée ou juste en dessous de la température ambiante prédéterminée conçue autour d’un refroidissement sensible.

Legrand propose ses solutions de refroidissement de la porte arrière ColdLogik/USystems. Pour Scott Bailey, « ces solutions ColdLogik/USystems, allant du refroidissement en rangée aux RDx (Rear Door Heat Exchanges), présentent l’avantage d’être une véritable solution évolutive et flexible qui utilise la tuyauterie existante des clients, réduisant ainsi les dépenses d’investissement initiales pour établir des solutions à plus haute densité. À titre d’exemple, les RDx ont maintenant la flexibilité de refroidir une armoire de 20 kW, avec la possibilité de l’adapter à 100-200 kW, car la technologie de l’IA et les solutions de calcul élevé augmentent leur demande d’alimentation et de refroidissement à la demande.

À l’heure actuelle, la solution de porte arrière est un moyen très efficace et rapide d’avoir une véritable flexibilité sur la croissance de la demande pour les entreprises de centres de données. Au fur et à mesure que nous constatons l’augmentation de la puissance et du refroidissement avec divers modèles d’IA et fabricants de puces, vous verrez diverses solutions de refroidissement hybrides. Une solution hybride typique que nous voyons actuellement sur le marché est une solution de refroidissement direct à la puce avec un modèle de porte arrière pour permettre une véritable croissance flexible et évolutive ».

Scott Bailey donne l’exemple de Bulk Data Centers qui s’est équipé de ses échangeurs de chaleur actifs à porte arrière CL 20 : « Bulk Data Centers, stratégiquement positionné dans les pays nordiques, tire parti du climat naturellement plus frais de la région pour optimiser l’efficacité du refroidissement. Cet avantage géographique est crucial car il permet à l’entreprise de réduire sa dépendance aux systèmes de refroidissement mécaniques, réduisant ainsi la consommation d’énergie et l’impact environnemental. En 2023, Bulk a investi dans le ColdLogik RHDx (échangeur de chaleur actif à porte arrière CL20), spécialement conçu pour gérer les densités de puissance élevées rendues nécessaires par les technologies informatiques modernes telles que les GPU, qui peuvent exiger jusqu’à 50 kW par rack.

Cette solution de refroidissement innovante s’intègre directement aux racks, extrayant la chaleur à la source et améliorant ainsi l’efficacité globale du refroidissement. Ce système permet à Bulk de répondre aux besoins des clients en matière de configurations à haute densité sans avoir besoin d’une expansion horizontale importante, qui nécessiterait plus de matériaux et d’espace. En augmentant la densité des rayonnages, Bulk maximise l’utilisation de l’espace et minimise l’empreinte environnementale de ses opérations.

Le premier déploiement du système ColdLogik RHDx dans les installations de Bulk a démontré des capacités exceptionnelles, atteignant une capacité de refroidissement moyenne de 40 kW par rack, avec des pics allant jusqu’à 60 kW. Cette capacité d’adaptation est essentielle pour répondre rapidement et efficacement aux demandes fluctuantes des clients. De plus, les commandes intelligentes du système assurent une gestion optimale de la température, s’alignant sur les stratégies hydroénergétiques à faible émission de carbone de la Norvège pour renforcer la durabilité. »

Data4 a fait le choix du Liquid Cooling dans son partenariat avec OVHcloud

Le groupe Data4, opérateur français sur le marché des datacenters, a noué en janvier 2024 un partenariat de long terme avec OVHcloud, qui a sélectionné le site de Marcoussis de Data4 pour y implanter son projet de couverture de la région Île-de-France. Parmi les solutions de pointe qui permettent de tendre vers davantage d’efficacité, le déploiement d’une technologie de liquid cooling – technologie de refroidissement des baies de serveurs avec de l’eau – apparaît comme l’une des solutions privilégiées. Dans cette logique, l’intégration de la technologie propriétaire de refroidissement à l’eau développée et opérée depuis plus de 20 ans par OVHcloud vient concrétiser cette approche.

L’interconnexion du leader européen du cloud aux systèmes de refroidissement de Data4 directement sur les boucles d’eau froide permet un gain de l’ordre de 25 % sur la consommation électrique par rapport au refroidissement à l’air classique, répondant à l’objectif de réduction de l’empreinte carbone. Enfin, Data4 a mis en place un usage responsable de l’eau au sein de ses infrastructures et affiche un WUE (Water Usage Effectiveness) très performant sur son campus de Marcoussis (0,06 l/kWh IT).

« Notre relation avec OVHcloud dépasse le simple cadre contractuel car il s’agit d’un véritable partenariat à long terme avec le champion du cloud européen. En partant des besoins spécifiques de notre client, nous avons ainsi développé une solution sur mesure pour permettre l’intégration de ses baies de serveurs refroidies à l’eau (liquid cooling). Tout comme OVHcloud, nous sommes très engagés dans la mesure et la réduction de notre empreinte carbone et nos outils dédiés sont très complémentaires (calculatrice carbone côté OVHcloud et Green Dashboard côté Data4) », précise Alexandre Delaval, Country Director France, Data4.

Digital Realty et Schneider Electric s’associent pour lancer une initiative d’économie circulaire dans les datacenters

Digital Realty, qui exploite 15 datacenters en France et plus de 300 dans le monde, et Schneider Electric ont annoncé, le 3 avril lors de l’Innovation Summit Paris 2024, une nouvelle initiative pour soutenir les engagements de Digital Realty en matière d’économie circulaire et de développement durable.

Ce projet vise à prolonger le cycle de vie et à maintenir les systèmes critiques du site de Paris 6 (PAR6), notamment ses équipements électriques basse tension (BT) et moyenne tension (MT), ses appareillages de commutation et ses onduleurs triphasés Schneider Electric, conformément aux engagements de Digital Realty en matière d’environnement, de société et de gouvernance (ESG). Cette démarche inclut la possibilité de réutiliser des éléments clés de son infrastructure et de ses composants électriques, tout en lançant de nouveaux programmes de reprise, de recyclage et de remise à neuf pour aider l’entreprise à réduire ses déchets d’équipements électriques et électroniques, ses émissions du Scope 3 et à éliminer les gaz à effet de serre nocifs (GES) tels que le SF6. Cette initiative innovante comprend un plan d’évaluation du rajeunissement des batteries, une première dans le secteur, afin de prolonger le cycle de vie des batteries VRLA des onduleurs de l’entreprise. Elle reposera en outre sur les principes de l’économie circulaire. Dans l’ensemble, l’ambition est de créer une feuille de route qui permette à Digital Realty de répliquer, déployer et étendre ses initiatives de circularité sur l’ensemble des sites en Europe.

« Nous adaptons en permanence notre stratégie et nos opérations pour répondre aux enjeux du développement durable : la circularité des équipements, en l’occurrence des équipements électriques, est l’un des leviers majeurs de décarbonation de nos activités et de notre chaîne de valeur. C’est là que notre collaboration avec Schneider Electric, partenaire depuis plus de 20 ans, prend tout son sens, explique Fabrice Coquio, senior vice-président et directeur général de Digital Realty France. Au cours des 3 à 5 prochaines années, le projet de circularité devrait aider Digital Realty à économiser et à éviter 50 à 70 % du carbone incorporé dans ses équipements BT, MT et UPS triphasés. »

Cette stratégie détaille également une approche de déploiement en 4 étapes qui prévoit la numérisation, le prolongement du cycle de vie, la remise à neuf et la réutilisation de ses équipements critiques avec l’aide de partenaires locaux, ainsi que la reprise, le remplacement et la mise au rebut responsable des ressources de ses infrastructures physiques. Cette approche permet à Digital Realty de moderniser et de réutiliser certaines pièces de ses onduleurs triphasés, tout en entreprenant des mises à niveau progressives, une maintenance conditionnelle et une numérisation dans le cadre de son contrat EcoStruxure Service Plan.

Digital Realty s’engage également à ce que tous ses sites en France atteignent un PUE< 1,30 en 2030 et à continuer d’utiliser 100 % d’énergie renouvelable produite en France.

« Alors que la croissance des datacenters portée par l’adoption de l’IA atteint un niveau record en Europe, il est impératif que les opérateurs explorent et innovent dans leurs approches en matière de développement durable, confirme Hélène Macela-Gouin, vice-présidente de l’activité Secure Power, Schneider Electric, France. Tandis que nous nous tournons vers l’avenir et que les demandes numériques sont en forte croissance, il est vital que le progrès technologique aille de pair avec les principes de l’économie circulaire afin de construire les centres de données de demain de manière responsable pour la prochaine génération. »

Les datacenters du Edge Computing vont aussi adopter le refroidissement liquide

Comme le note François Salomon, l’IA, la 5G, l’IoT et la haute densité vont gagner le Edge Computing. « Les architectures centralisées ne permettront pas de soutenir à terme le déploiement de ces services à grande échelle. Il y aura nécessité d’un traitement local de la donnée, notamment sur les charges d’inférence de l’IA et les traitements de calcul locaux. Par ailleurs, les solutions de liquid cooling, en s’affranchissant partiellement ou totalement de l’air pour refroidir les serveurs, sont particulièrement adaptées aux environnements contraints (espace limité, environnements poussiéreux ou corrosifs) et répondent en ce sens à certaines applications Edge dans l’Industrie, les environnements extérieurs exposés ou isolés…

Les solutions proposées sont sensiblement identiques à celle déployées actuellement dans le cloud, avec des solutions immersives de type châssis immersif, et des solutions Direct-to-Chip déployées sur 1 ou 2 racks pour héberger des serveurs de proximité. »

Pour Séverine Hanauer, « beaucoup d’entreprises, petites ou grandes, qui possèdent des petites salles informatiques, sont en effet intéressées par le Edge Computing, car le traitement informatique s’effectue au plus près des utilisateurs finaux et réduit ainsi le temps de transmission des données traitées. Les datacenters de proximité sont également intéressés par la technologie de refroidissement liquide. Ils y voient par exemple la possibilité d’avoir une architecture technique hybride avec une partie de leur site équipée de baies classiques alimentées par un système de refroidissement à air et dans une autre partie, des équipements refroidis par liquide et compatibles avec de la très haute densité. Ils peuvent ainsi répondre à une demande interne ou externe pour des clients qui souhaitent utiliser les processeurs les plus puissants ».

Le refroidissement liquide devrait permettre d’améliorer le PUE et le WUE

Aujourd’hui, tous les exploitants de datacenters cherchent à améliorer l’efficacité énergétique de leur site et donc de réduire leur PUE. Ce PUE, pour d’anciens datacenters, est souvent supérieur à 2. 1,3 est souvent la valeur visée pour réduire les coûts d’énergie en améliorant l’efficacité du refroidissement qui reste, et de loin, le plus gros poste de consommation d’électricité.

Pour François Salomon, « quelle que soit la solution déployée, le liquid cooling devrait permettre de réduire le PUE des datacenters autour de 1,1, voire une valeur inférieure ».

Ces solutions devraient également diminuer les consommations d’eau, donc le WUE (Water Usage Effectiveness) des centres de données, comme le souligne Séverine Hanauer : « Comme le refroidissement par liquide élimine la chaleur à la source, il peut être plus efficace que le refroidissement par air seul et permet de réduire les paramètres PUE des installations. Il utilise également de l’eau ou un fluide pour refroidir les systèmes et permet aux équipes de récupérer et de réutiliser la chaleur, réduisant ainsi le WUE (Water Usage Effectiveness). Après l’audit des systèmes et l’analyse comparative des données, les équipes peuvent saisir régulièrement des mesures démontrant les progrès accomplis dans la réduction du PUE et du WUE. Ces gains peuvent réduire les émissions indirectes ou réglementées par l’énergie (Scope 2) pour les entreprises. Par conséquent, le refroidissement liquide peut constituer un élément essentiel des programmes de développement durable des entreprises.

À ce stade, le refroidissement liquide est loin de remplacer le refroidissement par air dans tous les datacenters. Nombreux sont d’ailleurs les exploitants à se diriger vers des systèmes de refroidissement hybrides, répondant à des besoins spécifiques selon les zones des datacenters concernés. Ce qui implique aussi de disposer d’indicateurs de mesures adéquats, afin de prendre en compte la réduction attendue de la puissance de ventilation grâce aux systèmes de refroidissement liquide. Dès lors, le traditionnel PUE devra se doter de nouveaux paramètres de mesures, en accord avec les nouvelles méthodes de refroidissement ».

Mais l’IA présente aussi des opportunités pour les datacenters, comme le souligne Adam Levine, Chief Commercial Officer de Data4 Group : « Tout en entraînant un besoin de capacités accrues dans les datacenters, l’IA présente une multitude d’opportunités d’innovation du point de vue de l’amélioration de l’efficacité énergétique. Elle peut par exemple servir à l’analyse de données sur la consommation d’électricité et le refroidissement, en contribuant à les maintenir à un niveau optimal et en permettant d’ajuster les paramètres en temps réel. »

Jean-Paul Beaudet

Retrouvez le dossier page 27, J3e mai 2024 :