Le nombre de datacenters ne cesse d’augmenter avec, pour chacun d’eux, les mêmes impératifs de continuité de service, de sécurité et de performance environnementale. La gestion thermique reste un des points clés d’un bon fonctionnement de ces sites, mais elle doit évoluer en permanence pour répondre aux nouveaux besoins des équipements et applications, avec une gestion rigoureuse des coûts tout en améliorant la performance environnementale. Avec, en moyenne, près de 40 % de la consommation des datacenters allouée au refroidissement, de nouvelles tendances se dessinent aujourd’hui pour améliorer la performance énergétique de ces infrastructures critiques.

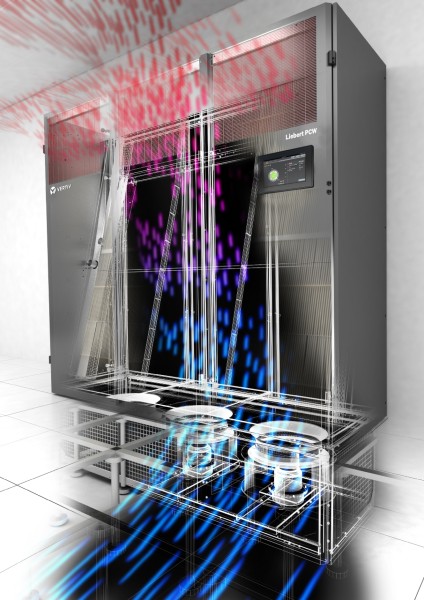

L’enjeu principal est de réduire l’empreinte carbone des datacenters. Ce marché est un grand consommateur d’électricité et les besoins en traitement de données sont en constante augmentation. Les datacenters sont aussi de plus en plus nombreux et la densité au sein des datacenters augmente. Les acteurs du datacenter veillent toujours plus à limiter leur impact, et les choix technologiques des exploitants visent à réduire les consommations. « Les solutions de refroidissement représentent en moyenne 38 % de la consommation électrique totale d’un datacenter. Comme l’ensemble des fabricants d’équipements IT ou d’infrastructure technique progressent, le ratio reste sensiblement le même depuis dix ans », explique Séverine Hanauer, Data Center & Telecom Sales Director de Vertiv France.

Favoriser une approche holistique

Le refroidissement est le premier levier de performance des datacenters. Dans des datacenters récents, l’objectif de PUE (Power usage effectiveness, indicateur d’efficacité énergétique, en français) se situe souvent entre 1,3 et 1,5. Dans les datacenters anciens, l’amélioration de la performance est difficile. « Pour une performance optimale des solutions de refroidissement, il faut une vision holistique de son datacenter et jouer sur l’urbanisation des salles », explique Didier Poulanges, directeur des ventes Data Center & Telecom de Stulz France. Trois facteurs principaux influent sur la performance des systèmes de refroidissement : le bâtiment, l’urbanisation et les choix technologiques. Si ces trois composantes sont étudiées au mieux, cela permet d’améliorer la performance énergétique. Ces trois éléments doivent être mis en corrélation avec la géographie et la situation climatique du lieu, afin de choisir les technologies les plus adaptées.

Amélioration du PUE

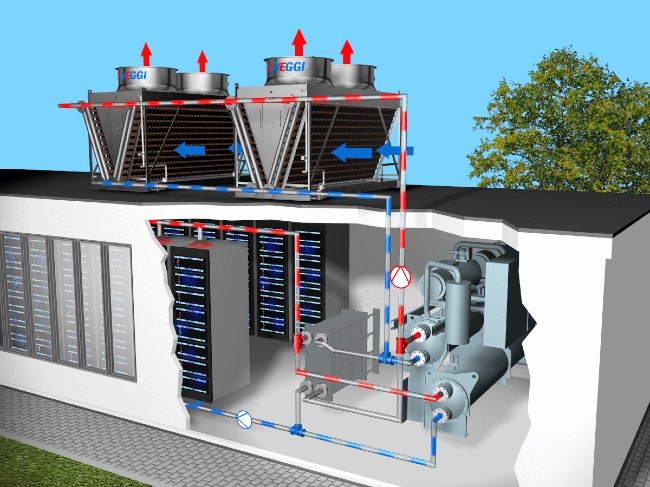

glacée free-cooling ou «Chiller Free-chilling» dont le cahier des charges

pour sa conception a été de répondre

au mieux aux besoins spécifiques

des applications datacenters. Fiable, performant et réfrigérant, le HFO 1234 Ze affiche un GWP (global warning potential) de 6. © Stulz

Il y a une quinzaine d’années, le PUE moyen était d’environ 3. Aujourd’hui, les exploitants visent un PUE réduit d’au moins la moitié. L’amélioration de la performance énergétique des systèmes de refroidissement vient principalement des innovations technologiques et de la multiplication des techniques disponibles. « Nous observons également une plus grande variété de systèmes de refroidissement, parfois associés sur une même installation pour une meilleure efficacité et une flexibilité optimisée », constate Séverine Hanauer.

Mesurer la performance au-delà du PUE

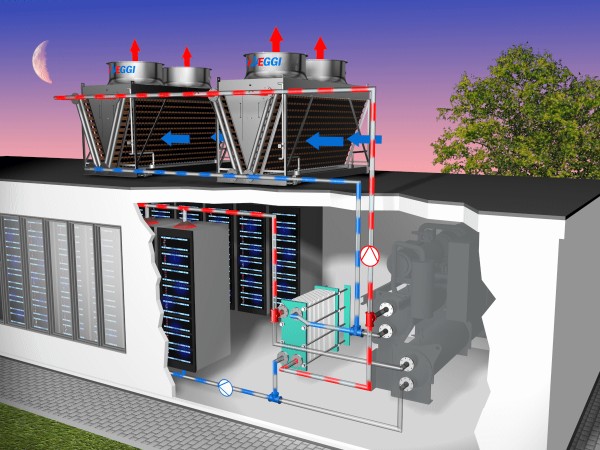

La mesure du PUE, qui se concentre sur la part d’électricité consommée par les serveurs au regard de l’électricité consommée par le refroidissement, montre aujourd’hui ses limites si elle ne prend pas en compte les consommations d’eau, comme l’explique Vincent Bitsch, directeur commercial Europe de Jaeggi : « Une nouvelle notion, le WUE (Water usage effectiveness, indicateur d’efficacité de l’utilisation de l’eau), offre, à nos yeux, un meilleur visuel du refroidissement en mettant en parallèle les consommations d’eau et d’électricité. En France, l’électricité n’est pas chère, ce qui biaise les performances. »

Zoom sur les différents modes de refroidissement

- Refroidissement sec avec échange convectif d’air

Ce système est limité et contraint par la température sèche extérieure. Il convient donc aux climats froids. S’il fait 45 °C dehors, il ne sera pas possible de refroidir le fluide en dessous de 45 °C. - Refroidissement adiabatique

Solution Fanwall Schneider Electric – jusqu’à 500 kW de capacité frigorifique pour une optimisation de l’espace IT. © Schneider Electric Il s’agit d’un système qui humidifie l’air pour refroidir le fluide. L’eau ruissèle sur des médias d’humidification pour faire baisser la température ambiante. Il présente un avantage psychologique, car il n’est pas soumis au règlement ICPE et consomme peu d’eau par rapport aux tours ouvertes.

- Les tours ouvertes

Elles restent le système le plus efficace pour refroidir un fluide, mais consomment énormément d’eau et sont soumises à la réglementation ICPE 2921. - Les refroidisseurs hybrides

Ils combinent le mode humide par ruissellement de l’eau sur les batteries et la convection forcée à l’aide de ventilateurs. Ils reprennent donc à la fois le principe des tours à ruissellement et des Dry Coolers. En été, le mode humide permet de refroidir davantage, la limite de température froide du fluide théorique est la température de bulbe humide. Ce système nécessite en moyenne deux fois moins de surface au sol que les systèmes adiabatiques et a un meilleur rendement.

Choisir le système le plus adapté

Selon la puissance du datacenter, la pertinence des technologies diffère, comme l’explique Ludovic Roy, responsable des ventes France et zones francophones de Tecnair LV : « Il existe deux modes de refroidissement. Les systèmes dits à détente directe et les systèmes à eau glacée. La détente directe est préconisée dans les datacenters de moins de 100 kW. Au-delà, un système à eau glacée est plus rentable. »

Ensuite viennent les différentes architectures, armoires périmétriques, InRow ou Coldwall. Là aussi, le choix dépend de la nature du datacenter. « S’il s’agit d’un minidata constitué d’une petite salle avec 4 à 5 baies, une armoire périmétrique soufflant en vrac sera la solution la plus adaptée. Pour les concentrations plus importantes avec un agencement en allées froides, les systèmes InRow permettent de s’affranchir du plancher technique », poursuit Ludovic Roy.

Pour les centres de données d’hébergement de plusieurs dizaines de mégawatts, ou pour les gros centres de plusieurs dizaines de kilowatts, les enjeux diffèrent. « Pour les hébergeurs, les datacenters sont un outil de travail et leur objectif est de réduire les consommations pour améliorer leur rentabilité. Pour les datacenters propriétaires, le seul objectif est lié à la continuité de service, et la performance énergétique n’est pas un enjeu stratégique », explique Didier Poulanges.

Enfin, pour un dimensionnement optimal, il est important de prendre en compte quatre éléments, comme l’explique Séverine Hanauer : « Il faut considérer le niveau de redondance souhaité ou imposé et limiter le nombre d’équipements nécessaires sur le site au final, tout en tenant compte du phasage d’évolution de puissance du site et de l’impact que les différents niveaux de charge intermédiaires peuvent avoir sur le système de refroidissement et son rendement. »

Les hébergeurs traditionnels utilisent des boucles d’eau glacée, du freecooling adiabatique ou le refroidissement directement dans les serveurs. « En France, ce sont principalement les systèmes de refroidisseurs adiabatiques qui sont plébiscités du fait de la réglementation ICPE 2921. En Europe, sur les grosses installations, ce sont plutôt les systèmes hybrides qui sont plébiscités », détaille Vincent Bitsch.

Récupérer la chaleur produite par les datacenters

La récupération de la chaleur des datacenters pose de nombreuses questions, liées notamment à la complexité de la mise en œuvre. Quelques projets ont émergé, notamment pour chauffer des piscines implantées à proximité des centres de données. « Ce domaine mériterait une véritable exploration. Les datacenters ont une charge constante, ce qui pose un problème d’usage de la chaleur. Chauffer une piscine ou alimenter des bâtiments en ECS nécessite plus de besoins l’hiver. Que fait-on alors de cette eau chaude l’été ? D’autant que la température de l’eau en sortie est assez basse, de l’ordre de 30 à 40 °C », explique Vincent Bitsch. Ce que confirme Didier Poulanges : « Par exemple, pour un bassin de piscine, il faut environ 100 kW, alors qu’un moyen datacenter produit plutôt de l’ordre d’un mégawatt. Que fait-on de cette chaleur ? Pour quels usages ? D’autant qu’il s’agit d’un mégawatt de température faible, ne dépassant pas les 35 °C. Tant que les datacenters seront en dehors de la ville, il sera difficile de trouver des installations pertinentes. »

Les projets se heurtent également aux coûts d’installation, parfois très élevés, et le dimensionnement doit être adapté, comme l’explique Séverine Hanauer : « La récupération de chaleur est possible si une application voisine est adaptée pour récupérer l’air chaud du datacenter. Il y a un ensemble d’équipements à mettre en place, ce qui grève le coût d’un projet. Il faut prévoir un dimensionnement et une conception du datacenter adaptés aux besoins en chaleur à fournir. »

jusqu’à 7,7. ©Schneider Electric

D’autres freins compliquent le développement des projets de récupération de chaleur, comme l’explique François Salomon : « La récupération de chaleur pose problème pour la continuité de service du datacenter : interconnecter un réseau de chaleur à usage tertiaire et un réseau process ne plaît pas aux hébergeurs. Par ailleurs, la chaleur se transporte mal et ces installations nécessitent de multiplier les infrastructures et les coûts. Il y a enfin une contradiction forte entre les infrastructures free-chilling, qui visent à limiter l’usage des circuits à détente directe et représentent maintenant la norme dans les datacenters, et la récupération de chaleur qui implique de faire fonctionner ces circuits. Le bilan énergétique global de ces solutions serait très pertinent, mais il n’a pas encore trouvé son modèle économique en France. » Ce sujet devra faire l’objet de développements et certains articles de loi obligent d’ores et déjà les acteurs à réaliser des études sur la récupération d’énergie avant même d’implanter un datacenter.

Pour les petits datacenters

Pour le Edge et les applications de micro-informatique dans les bureaux, en dessous de 3 kW IT, les serveurs sont intégrés dans une armoire, avec une ventilation simple qui tire l’air du bâtiment dans le rack.

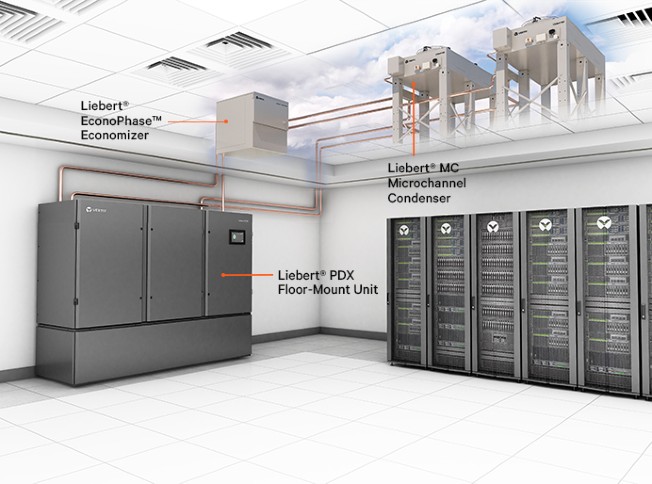

Pour les petites salles de 10 à 15 kW, les solutions à détente directe sont favorisées. Une unité intérieure refroidit et une unité extérieure rejette les calories. Les solutions InRow sont souvent privilégiées, car elles ne nécessitent pas de plancher technique et apportent une solution efficace, résiliente et simple à déployer.

Pour les datacenters de taille moyenne

Au-delà de 15 kW et jusqu’à 150 kW, les solutions à détente directe sont là encore privilégiées, car elles représentent le meilleur compromis technico-économique. La détente directe présente également l’avantage de simplifier la mise en place de redondance (normal/secours) avec la mise à disposition d’unités de climatisation indépendantes les unes des autres. Néanmoins, de nombreux hébergeurs préfèrent la mise en œuvre de solutions fonctionnant à l’eau glacée, avec une production centralisée d’eau froide qui alimente l’ensemble du datacenter. « L’eau glacée est plus souple d’utilisation que la détente directe et plus simple à réguler finement. Les régimes d’eau glacée se situent entre 15 et 20 °C, avec une tendance à l’augmentation des régimes de température entre 20 et 25 °C. Les leviers d’optimisation de la consommation énergétique, avec la mise en œuvre de free-chilling, sont bien plus importants en eau glacée qu’en détente directe », explique François Salomon, directeur de l’activité Froid Climatisation – IT Division de Schneider Electric France.

Pour les plus gros datacenters

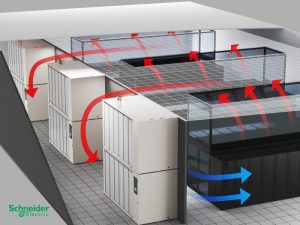

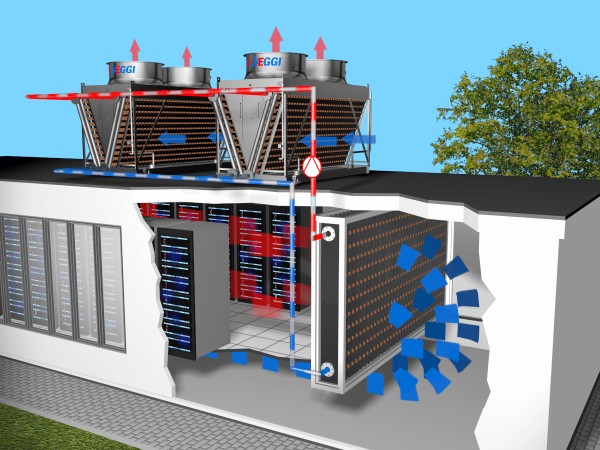

Au-delà de 150 kW, les datacenters sont refroidis par des Air CRAC (unités de climatisation pour les salles de serveurs) et des

Fanwalls (murs de ventilation), qui fonctionnent tous deux à l’eau glacée. « Aujourd’hui, avec l’augmentation des régimes d’eau glacée, il est nécessaire de privilégier des terminaux de ventilation plus puissants. Les armoires sont conçues pour avoir une plus grande surface d’échange avec une diffusion d’air en couloir froid, soit via un plancher technique, soit directement dans la salle IT. La tendance est à l’usage d’armoires de climatisation ou Fanwall de très fortes puissances (jusqu’à 500 kW) permettant de limiter les coûts d’investissement et d’intégration, tout en conservant un niveau très élevé de performance, quelle que soit la charge du datacenter », poursuit François Salomon.

Chaque solution, si elle est bien utilisée, est aussi efficace qu’une autre. Il faut dès lors envisager chaque solution dans son ensemble et tenir compte des besoins du client en termes de redondance, de coûts d’acheminement et de mise en place. Le parcours des tuyauteries d’eau glacée ou le nombre de raccordements hydrauliques et électriques ont eux aussi leur importance. « Une maintenance aisée participe à la diminution des coûts et augmente ainsi l’efficacité globale du système », précise Ludovic Roy.

Urbaniser les salles de serveurs

Depuis plusieurs années, l’urbanisation s’est imposée comme vecteur de performance. Les salles sont constituées de zones froides, sur la face avant des serveurs, et de zones chaudes sur la face arrière. D’importants progrès ont été réalisés dans l’urbanisation, qui ont ouvert la voie à l’augmentation des régimes de température. « Auparavant, l’ensemble des salles de serveurs étaient réfrigérées à 15 °C, alors qu’aujourd’hui, les couloirs confinés amènent de l’air à 25 °C dans les serveurs et le rejettent entre 35 et 40 °C. Cette augmentation des régimes de température permet une réelle amélioration de la performance énergétique », explique François Salomon. Ainsi, l’Ashrae (American Society of Heating, Refrigerating and Air‑Conditioning) conseille depuis 2011 une température des salles comprise entre 15 et 32 °C. « Le simple fait de maintenir une salle à 27 °C au lieu de 22 vous permet de remonter votre régime d’eau glacée et de faire de substantielles économies », commente Ludovic Roy.

Favoriser le pilotage

Au-delà du matériel, qui fait l’objet d’améliorations permanentes, il est important de se concentrer sur le pilotage des équipements, qui permet d’adapter le refroidissement à la demande. « L’adoption de débit variable permet d’adapter les systèmes à la demande, ce qui ouvre la voie à un pilotage plus fin », explique Didier Poulanges. Tout comme l’usage de moteurs à courant continu, qui permettent de faire varier la vitesse et le couple et peuvent être raccordés directement à la source d’énergie, comme l’explique Ludovic Roy : « Depuis plusieurs années, l’usage de moteurs à courant continu est devenu la norme dans les systèmes de climatisation. » Par exemple, s’il faut produire 10 000 m3 d’air pour les serveurs, la climatisation doit s’adapter. Il ne faut pas surclimatiser ou surventiler. « La régulation fine du débit d’air, du débit d’eau et du fonctionnement des compresseurs est un véritable levier de performance, que ce soit pour les micro- ou les mégadatacenters. Plus les datacenters sont grands, plus les gains en euros sont importants », explique Didier Poulanges.

Une polarisation du marché

Aujourd’hui, le marché se polarise, entre de très petits datacenters propriétaires dans les bureaux et de très gros datacenters d’hébergement. « Les PME abandonnent leurs propres infrastructures et externalisent leurs données en faisant appel à des hébergeurs privés. De grands groupes (Casino, Amazon) font de même et cela permet l’avènement de datacenters de plusieurs milliers de mètres carrés (Iliad, Interxion, OVH). Cette centralisation réduit les coûts d’exploitation. Cependant, certains acteurs nécessitant une totale maîtrise de leurs flux de données rénovent leurs datacenters », décrit Ludovic Roy.

Les technologies progressent

Au-delà de l’urbanisation, du pilotage des infrastructures et de l’augmentation des régimes de température, les équipementiers font constamment évoluer les technologies. C’est le cas pour les fluides frigorigènes : « Toute la profession migre vers les fluides frigorigènes, plus respectueux de l’environnement, avec un PRG (pouvoir de réchauffement global) le plus petit possible : aujourd’hui, plutôt des fluides de type HFO », explique François Salomon. « Les réfrigérants évoluent selon les directives, avec de nouvelles générations tous les 2-3 ans, qui permettent de réduire leur empreinte carbone », complète Séverine Hanauer.

Les composants des systèmes de refroidissement évoluent également avec, par exemple, de nouvelles générations de ventilateurs aux formes plus aérodynamiques, l’utilisation de matériaux plus légers, l’arrivée de systèmes de régulation plus performants et intelligents. « Tout cela contribue à l’optimisation de la performance énergétique des systèmes de refroidissement », explique Séverine Hanauer.

« Nous constatons l’arrivée de ruptures technologiques dans des projets de R&D, mais qui n’aboutissent le plus souvent pas ou rarement et dépendent de la volonté des décideurs. Dans certains cas, il s’agit d’augmenter les régimes de température des serveurs, pour réduire ou supprimer les besoins en refroidissement. Nous voyons également arriver du refroidissement direct sur systèmes à eau, mais ces technologies sont encore très confidentielles », conclut Didier Poulanges.

Alexandre Arène