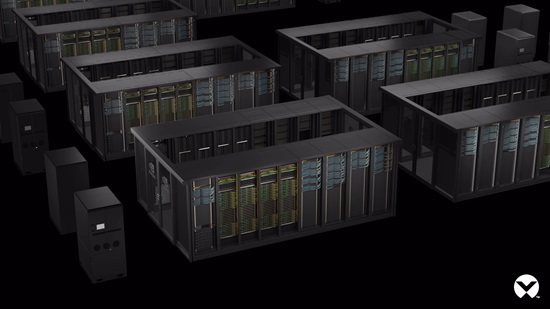

L’approche globale adoptée par Vertiv et NVIDIA optimise la vitesse de déploiement, les performances, la résilience, le coût et l’efficacité énergétique des data centers actuels et futurs.

Cette conception de référence de bout-en-bout, conçue pour transformer les data centers classiques en « usines d’IA », permettra de déployer rapidement des infrastructures capables de supporter jusqu’à 132 kW par rack, avec une puissance totale de 7 MW.

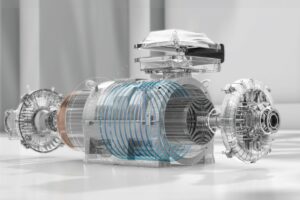

L’approche globale adoptée par Vertiv et NVIDIA optimise la vitesse de déploiement, les performances, la résilience, le coût et l’efficacité énergétique des data centers actuels et futurs. Elle combine des technologies avancées d’alimentation et de refroidissement, incluant un système hybride de refroidissement liquide et par air pour gérer efficacement la dissipation thermique à haute densité.

Parmi les avantages clés de cette architecture, on note un déploiement jusqu’à 50% plus rapide grâce aux modules préconfigurés Vertiv™ MegaMod™ CoolChip™, une gestion d’énergie optimisée avec un encombrement réduit de 40%, et des coûts de refroidissement annuels diminués de 20% grâce à l’utilisation de technologies à faible potentiel de réchauffement global.

Cette collaboration s’inscrit dans la stratégie de Vertiv visant à redéfinir l’avenir de l’infrastructure critique pour l’informatique accélérée et l’IA. Elle établit une feuille de route pour le co-développement technique et facilite le déploiement à grande échelle de solutions d’informatique accélérée, répondant ainsi à l’adoption croissante de l’IA par les entreprises.