Le développement récent et rapide de l’intelligence artificielle (IA), de l’apprentissage automatique et du calcul haute performance (HPC) nécessite des datacenters à haute densité avec des exigences complexes en matière d’alimentation, d’urbanisation et surtout de refroidissement. Ces sites peuvent aussi avoir à faire face à l’augmentation du coût de l’énergie et à des problèmes de surface. De nouvelles solutions techniques sont disponibles pour intégrer tous ces enjeux et s’adapter rapidement.

L’IA comme le calcul haute performance (HPC) sont des technologies qui utilisent des serveurs puissants travaillant en parallèle pour traiter de très grandes quantités de données (big data). Les applications sont très nombreuses et se développent tous les jours dans l’industrie, le domaine médical et financier ou encore le véhicule autonome. Ces deux domaines, IA et HPC, sont de plus en plus liés avec l’adoption de l’IA pour les applications de calcul haute performance.

Toutes ces nouvelles applications nécessitent une innovation rapide dans la conception, la technologie et la gestion des datacenters avec de nouvelles solutions techniques fiables et efficaces énergétiquement et adaptables rapidement à l’évolution des besoins des clients.

D’où, comme le confirme Hélène Macela-Gouin, vice-présidente Secure Power de Schneider Electric France, « un marché très dynamique avec beaucoup de nouveaux datacenters. En 2022, nous comptions environ 250 datacenters. Nous estimons l’augmentation à + 11 % par an pour les dix prochaines années, avec une filière qui prévoit d’investir 12 milliards d’euros dans les dix prochaines années, majoritairement en région parisienne ».

Ce développement très rapide, explique-t-elle, pose de nouvelles questions en matière de conception et d’exploitation des datacenters :

- Plus d’IT dans moins d’espace.

- La densification des serveurs oblige à passer du refroidissement par air au refroidissement liquide.

Dans ce contexte, pour Victor Avelar, Chief Research Analyst, Energy Management Research Center de Schneider Electric, « des grands clusters jusqu’aux petits serveurs d’inférence, l’IA représente une part de plus en plus importante de la charge de travail dans les datacenters. Cette évolution se traduit par des densités de puissance plus élevées. Les startups dans le domaine de l’IA, les entreprises, les services de colocation et les géants de l’internet doivent prendre en compte ces niveaux de densité, lors de la conception et de la gestion de l’infrastructure physique des datacenters. Nous estimons que l’IA représente aujourd’hui 4,3 GW de besoin en électricité et nous prévoyons que ces besoins augmenteront de 26 % à 36 % par an, pour atteindre une demande totale de 13,5 GW à 20 GW d’ici 2028. Ce besoin en électricité est deux à trois fois supérieur au taux de croissance annuel moyen des datacenters, qui est de 11 %. Nous pouvons en tirer un enseignement principal, à savoir que les charges d’inférence augmenteront à mesure que les nouveaux modèles passeront en production. La demande en énergie dépendra de facteurs technologiques, en particulier des prochaines générations de serveurs, de consignes plus efficaces, de l’amélioration des performances des microprocesseurs et de la recherche sur l’IA.

La plupart des datacenters actuels peuvent supporter des pics de densités de puissance 10 à 20 kW. Cependant, déployer des dizaines ou de centaines de racks de plus de 20 kW dans un cluster d’IA pose des problèmes d’infrastructure physique. Ces problèmes peuvent être spécifiques à l’alimentation ou concerner d’autres éléments de l’infrastructure physique. Ils ne sont pas insurmontables, mais ils demandent une parfaite connaissance des infrastructures informatiques et physiques, en particulier dans les datacenters existants. Plus l’installation est ancienne, plus il sera difficile de supporter des charges de travail d’apprentissage automatique ».

Une évolution qui va impacter tous les centres de données

Les opérateurs de datacenters doivent réduire, ou tout au moins limiter leur consommation d’énergie tout en répondant rapidement aux nouveaux besoins de leurs clients/utilisateurs. Cela va avoir un impact sur les équipements et systèmes de refroidissement qui doivent être remplacés par des technologies adaptées à la hausse des puissances tout en restant plus économes en énergie.

L’alimentation électrique doit aussi prendre en compte la montée en puissance des applications et il faut raisonner de plus en plus en termes d’évolutivité des équipements (UPS, batteries, distribution électrique), de modularité et de maintenabilité, et de durabilité à long terme des solutions retenues.

L’indicateur d’efficacité énergétique PUE (Power Usage Effectiveness) s’est amélioré ces dernières années, mais peine à descendre au-dessous de 1,2 pour les meilleurs datacenters, mais des innovations sont nécessaires pour obtenir de nouveaux gains, en particulier au niveau du refroidissement, qui reste un très gros poste de consommation.

Pour les salles existantes et en évolution, le problème de surface au sol de tous ces nouveaux équipements est aussi un paramètre important lors de l’évaluation complète de l’infrastructure et de son adaptation aux nouveaux besoins et de la coexistence avec les anciennes applications.

Grâce à des capacités de conception prêtes pour l’IA, certains sites de colocation sont déjà prêts à gérer des charges de travail spécialisées à haute densité et à faire face à l’évolution rapide des besoins et des environnements des centres de données.

Les solutions de datacenters modulaires peuvent aussi répondre aux besoins des entreprises de l’IA à la périphérie (Edge) en fournissant l’infrastructure, la puissance de calcul, la puissance électrique et le refroidissement nécessaires.

L’IA peut également être un outil pour la gestion du datacenter avec l’automatisation, l’analyse de données et l’apprentissage automatique alimentés par l’IA pour réaliser des gains en matière d’efficacité énergétique et de gestion optimisée du datacenter. Les opérateurs peuvent par exemple utiliser l’analyse prédictive pour apporter des améliorations en temps réel dans des domaines tels que le refroidissement ou la gestion de l’espace des baies. Les algorithmes d’IA peuvent aussi détecter des problèmes avant qu’ils ne se produisent et permettre une maintenance prédictive et une gestion dynamique des charges de travail.

Des solutions de refroidissement qui doivent s’adapter à ces nouveaux besoins

Le refroidissement a toujours été un élément important de la structure et du fonctionnement des datacenters, et la réduction de sa consommation d’énergie, mais aussi d’eau a toujours été un défi pour les concepteurs de solutions de refroidissement.

Ainsi, Carrier propose des solutions CVC complètes pour les datacenters en insistant sur la responsabilité environnementale : « Les datacenters de demain ont une responsabilité environnementale et une nécessité de décarbonation à prendre en compte dès les prémices de leur conception.

Plusieurs éléments sont donc à prendre en considération tels que l’optimisation du PUE (Power Usage Effectiveness), l’utilisation intelligente de l’énergie et de la chaleur, limiter le renouvellement des équipements, mesurer la consommation instantanée du parc de machines…

L’utilisation de fluide à bas GWP, la récupération de chaleur, le free cooling et l’amélioration des performances machines sont autant de technologies que Carrier met en place pour vous aider à réduire l’empreinte carbone des data centers. »

La régulation Carrier permet l’utilisation du free cooling dès que la température d’air extérieur est inférieure à la température de retour du réseau d’eau. Carrier intègre cette technologie dans ses unités de refroidissement air/eau, mais aussi dans ses centrales de traitement d’air pour un free cooling aéraulique direct ou indirect.

Carrier vient de lancer une nouvelle gamme de groupes de production d’eau glacée à hautes performances pour les datacenters, étudiée pour utiliser le moins d’énergie possible et abaisser les émissions de carbone, tout en permettant aux opérateurs de réduire leurs coûts d’exploitation. Avec plusieurs tailles disponibles comprises entre 400 kW et 2 100 kW, ces groupes certifiés Eurovent et AHRI reprennent la formule éprouvée des compresseurs à vis Carrier, gage de rendement, de fiabilité et de longue durée de service.

Ces nouveaux groupes de production d’eau glacée à vis et condensation par air AquaForce 30XF sont 100 % vitesse variable et équipés d’un free cooling hydraulique intégré, une association permettant des économies d’énergie pouvant atteindre 50 % en free cooling total.

Proposés avec un fluide frigorigène HFO à potentiel de réchauffement global ultra bas, le R-1234ze(E), ces groupes sont particulièrement résilients grâce à leur système de redémarrage ultra rapide qui, en cas de coupure de courant, est capable de revenir à 100 % de la puissance frigorifique dans les deux minutes qui suivent le rétablissement du réseau électrique. C’est la garantie que les serveurs sensibles ou critiques sont en permanence refroidis et les données protégées.

« Le nouvel AquaForce 30XF a été spécialement conçu pour répondre aux exigences strictes des datacenters sur l’environnement, l’efficacité et la fiabilité, et pour faire en sorte que les serveurs restent refroidis 24 heures sur 24, explique Raffaele D’Alvise, directeur marketing et de la communication pour Carrier HVAC. Ce groupe de production d’eau glacée aide les opérateurs de datacenters à atteindre leurs objectifs en termes de budget et de développement durable, en réduisant la consommation d’énergie et les émissions de carbone, tout en offrant un excellent niveau de résilience et une durée de service étendue ».

Le groupe AquaForce 30XF s’insère dans la gamme complète des solutions de refroidissement que propose Carrier pour les datacenters, une gamme qui comprend les groupes AquaSnap™ 30RBP (production d’eau glacée scroll à condensation par air) et AquaEdge™ 19DV (production d’eau glacée centrifuge à condensation par eau), la pompe à chaleur eau-eau AquaForce 61XWHZE, auxquels s’ajoutent les climatiseurs pour les salles informatiques, les centrales de traitement d’air et les ventilateurs muraux, qui tous sont pris en charge sur leur cycle de vie par la plateforme de services et d’assistance BluEdge™ de Carrier, afin que leurs performances soient toujours optimales.

Carrier insiste aussi sur la récupération de la chaleur fatale des datacenters. « Cette récupération de chaleur fatale consiste en la captation de la chaleur produite par les équipements pour être ensuite utilisée pour la production d’énergie thermique des réseaux urbains ou des bâtiments tertiaires et industriels. Carrier propose des équipements pour récupérer et valoriser la chaleur produite par les datacenters grâce à ses pompes à chaleur. La haute température ainsi produite optimise cette intégration dans des environnements urbains ou industriels au profit des utilisateurs locaux. Ces solutions de valorisations énergétiques permettront, à terme, une réduction significative de l’utilisation d’énergies fossiles (gaz, fioul…) par les utilisateurs de production de chaleur (réseaux, industries, complexes immobiliers). »

Les systèmes existants les plus performants restent bien adaptés jusqu’à des puissances par rack de 30 à 50 kW, mais au-delà il faut faire appel à de nouvelles techniques basées sur le refroidissement liquide. Car, comme le souligne Paul Lin, Research Director, Global Energy Management Research Center de Schneider Electric, « de nombreux serveurs d’IA dotés d’accélérateurs (par exemple de processeurs graphiques GPU) sont utilisés pour la formation des LLM (modèles d’apprentissage automatique de langage). Le refroidissement par air des puces peut être compliqué, compte tenu de la taille du dissipateur de chaleur, du débit d’air et de l’efficacité énergétique. Leurs charges de travail d’inférence génèrent suffisamment de chaleur pour avoir recours à un système de refroidissement liquide. Le refroidissement par eau dispose d’une meilleure capacité énergétique par rapport au refroidissement par air en raison de la capacité supérieure de l’eau à absorber la chaleur par rapport à l’air. Ces serveurs, équipés de tuyauteries en entrée et sortie, nécessitent des collecteurs, des CDU (unités de distribution de liquide de refroidissement) et un rejet de chaleur vers l’extérieur ».

Des technologies de refroidissement liquide variables selon les clients

Différentes solutions de refroidissement liquide sont aujourd’hui proposées pour s’adapter aux besoins des exploitants de datacenters en tenant compte de la croissance future de la charge de travail du site.

Séverine Hanauer de Vertiv souligne : « Pour évacuer la quantité massive de chaleur générée par le matériel exécutant des charges de travail d’IA, deux technologies de refroidissement liquide sont aujourd’hui principalement utilisées :

- Refroidissement liquide direct sur puce (D2C) : les plaques froides sont placées au-dessus des composants produisant de la chaleur (généralement des puces comme les CPU et les GPU) pour évacuer cette chaleur. Le fluide monophase ou biphase pompé extrait la chaleur de la plaque froide pour l’envoyer hors du datacenter. Cette extraction de chaleur se fait sans contact direct du fluide avec les puces.

Cela peut traiter environ 70 à 75 % de la chaleur générée par l’équipement dans le rack, ce qui laisse 25 à 30 % que les systèmes de refroidissement à air doivent éliminer. - Portes froides arrière : les portes froides, passives ou actives, remplacent la porte arrière classique de la baie informatique par des serpentins d’échange de chaleur à travers lesquels le fluide absorbe la chaleur produite dans la baie. Ces systèmes sont souvent associés à d’autres systèmes de refroidissement, soit comme stratégie pour maintenir une température constante dans la pièce, soit comme conception transitoire pour démarrer le processus vers le refroidissement liquide.

Une troisième solution technologique émerge pour les densités extrêmes, essentiellement celles supérieures à 70 kW : l’immersion cooling. Un système de refroidissement par immersion nécessite un réagencement de la salle informatique. En effet, l’organisation standard en rangées de racks informatiques verticaux est remplacée par des réservoirs horizontaux dans lesquels les équipements sont intégralement immergés dans un fluide diélectrique thermoconducteur. Le refroidissement par immersion est une technologie prometteuse, mais pas encore complètement mature, car elle manque encore de normes précises. Sans compter le développement nécessaire des compétences des équipes d’exploitation des datacenters pour être tout à fait opérationnelles sur ces nouvelles solutions, leurs enjeux et leurs contraintes.

Bien que le refroidissement liquide direct sur puce offre une puissance de refroidissement d’une densité nettement supérieure à celle de l’air, il est important de noter qu’il y a toujours une petite partie de chaleur dissipée que les plaques froides ne peuvent pas capturer. Cette chaleur sera rejetée dans la salle informatique à moins qu’elle ne soit contenue et éliminée par d’autres moyens tels que les portes froides à l’arrière des baies IT ou un autre système de refroidissement classique dans la salle. »

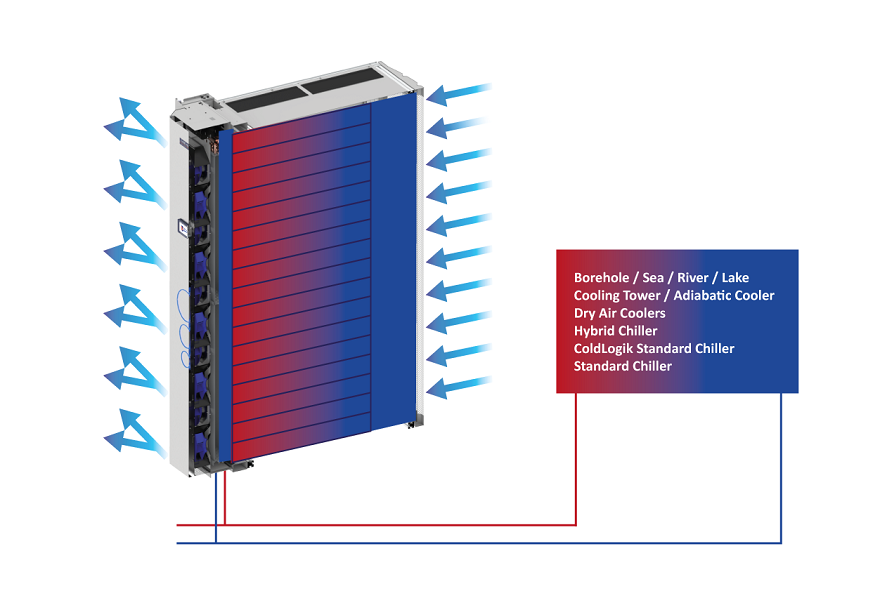

Legrand a développé avec sa filiale USystems des solutions d’échangeur de chaleur de porte arrière (RDHx), également connues sous le nom de refroidisseur de porte arrière (RDC). Cette technologie de refroidissement liquide éprouvée, parfois connue sous le nom de refroidissement liquide assisté par air, est conçue pour fonctionner comme un système en boucle fermée.

L’air ambiant est aspiré dans le rack par les ventilateurs de l’équipement informatique. L’air chaud évacué est expulsé de l’équipement et aspiré sur l’échangeur de chaleur assisté par des ventilateurs montés dans le châssis RDC. L’air évacué transfère la chaleur dans le liquide de refroidissement à l’intérieur de l’échangeur de chaleur, et l’air nouvellement refroidi est expulsé dans la pièce à la température ambiante prédéterminée ou juste en dessous de la température ambiante prédéterminée conçue autour d’un refroidissement sensible.

Legrand propose ses solutions de refroidissement de la porte arrière ColdLogik/USystems : « Pour Scott Bailey, CE0 de Legrand-USystems, ces solutions ColdLogik/USystems, allant du refroidissement en rangée aux RDX (Rear Door Heat Exchanges), présentent l’avantage d’être une véritable solution évolutive et flexible qui utilise la tuyauterie existante des clients, réduisant ainsi les dépenses d’investissement initiales pour établir des solutions à plus haute densité. À titre d’exemple, les RDX ont maintenant la flexibilité de refroidir une armoire de 20 kW, avec la possibilité de l’adapter à 100-200 kW, car la technologie de l’IA et les solutions de calcul élevé augmentent leur demande d’alimentation et de refroidissement à la demande.

À l’heure actuelle, la solution de porte arrière est un moyen très efficace et rapide d’avoir une véritable flexibilité sur la croissance de la demande pour les entreprises de centres de données. Au fur et à mesure que nous constatons l’augmentation de la puissance et du refroidissement avec divers modèles d’IA et fabricants de puces, vous verrez diverses solutions de refroidissement hybrides. Une solution hybride typique que nous voyons actuellement sur le marché est une solution de refroidissement direct à la puce avec un modèle de porte arrière pour permettre une véritable croissance flexible et évolutive ».

Et, ajoute Marc Marazzi : « Nos refroidisseurs de porte arrière ColdLogik permettent de refroidir jusqu’à 200 kW/rack en utilisant 800 watts de puissance pour cette porte arrière particulière. Maintenant, si nous imaginons ce que coûte le fonctionnement d’une unité CRAC pour fournir cela, c’est incroyablement inefficace par rapport à ce qu’un refroidisseur de porte arrière peut réaliser. Et avec les refroidisseurs de porte arrière, vous pouvez commencer petit, donc vous refroidissez, disons, 72 racks, et si vous en avez besoin de plus, vous ajoutez simplement des ventilateurs. »

L’impact de l’IA et du HPC pour l’informatique de proximité ou Edge Computing

L’arrivée de l’IA ne se limite pas aux grands datacenters de plusieurs milliers de mètres carrés en périphérie des grands centres européens, Paris, Marseille, Londres, Francfort ou Amsterdam. Les possibilités d’utilisation de l’IA étant presque illimitées, allant de la fabrication à la santé et la finance, le transport ou les commerces, elles exigent de nouvelles approches pour l’informatique à la périphérie qui est aussi concernée.

Comme le souligne Rémi Pouchucq, directeur commercial France-Data Center & Revendeurs IT de Schneider Electric, « l’IA va avoir un impact significatif sur l’edge computing ou informatique de proximité, transformant la manière dont les données sont traitées, analysées et utilisées en périphérie du réseau (près des dispositifs finaux comme les capteurs IoT, les caméras de surveillance ou les smartphones) ».

Et Rémi Pouchucq détaille les principaux impacts et avantages de cette combinaison :

- Traitement en temps réel et réduction de la latence

L’un des avantages majeurs de l’edge computing est de réduire la latence en traitant les données à proximité de leur source. En intégrant des modèles d’IA directement sur les dispositifs en bordure du réseau, il devient possible d’obtenir des analyses et des prises de décision en temps réel, sans dépendre d’un centre de données centralisé. Cela est particulièrement crucial pour des applications comme les véhicules autonomes, la reconnaissance d’images en temps réel, et la surveillance des infrastructures industrielles.

- Optimisation de l’utilisation de la bande passante

Le transfert de grandes quantités de données vers le cloud pour traitement peut être coûteux et inefficace. Grâce à l’IA en edge computing, une grande partie du traitement peut être effectuée localement, envoyant uniquement les informations nécessaires au cloud. Cela allège les réseaux, réduit les coûts et permet une meilleure gestion des ressources.

- Sécurité et confidentialité des données

L’IA appliquée en périphérie permet de renforcer la confidentialité des données en les traitant localement. Par exemple, dans le domaine de la santé ou de la vidéosurveillance, les données sensibles peuvent être analysées sur place, limitant leur transfert et donc leur exposition à des risques de sécurité. Les modèles d’IA peuvent aussi intégrer des mécanismes de détection d’anomalies en temps réel pour repérer et réagir face aux menaces de sécurité locales.

- Personnalisation des services et adaptation locale

En utilisant l’IA sur les dispositifs edge, il devient possible de personnaliser les réponses en fonction de l’environnement local ou des préférences des utilisateurs. Par exemple, dans un bâtiment intelligent, l’IA peut ajuster les systèmes de chauffage, de climatisation et d’éclairage en fonction de la présence des occupants ou des conditions climatiques en temps réel, ce qui améliore l’efficacité énergétique et le confort des utilisateurs.

- Résilience et autonomie accrue

Le traitement local avec l’IA rend les systèmes plus résilients, car ils peuvent continuer de fonctionner même en cas de coupure de connexion avec le cloud. Dans des contextes comme les villes intelligentes, les sites industriels isolés, ou les applications militaires, cette autonomie est cruciale pour la continuité des opérations.

- Réduction des coûts énergétiques

L’utilisation de l’IA en périphérie permet une gestion optimisée de l’énergie en adaptant les processus aux besoins en temps réel. Par exemple, l’IA peut prédire et ajuster la consommation d’énergie des dispositifs edge en fonction des modèles d’utilisation, ce qui contribue à une meilleure efficacité énergétique globale.

- Support aux applications IoT massives

Avec l’augmentation exponentielle des objets connectés, l’IA sur l’edge est essentielle pour gérer le volume de données généré par ces appareils. Elle permet de filtrer, pré-traiter et prioriser les données avant qu’elles soient envoyées au cloud, allégeant ainsi la charge sur les systèmes centraux et rendant l’IoT plus scalable.

« En résumé, explique Rémi Pouchucq, l’IA améliore l’efficacité, la sécurité, la réactivité et la personnalisation des services offerts par l’edge computing. Elle favorise une informatique décentralisée et autonome, capable de répondre aux besoins modernes d’une manière flexible et efficiente, tout en réduisant la dépendance aux infrastructures cloud centralisées. L’alliance entre l’IA et l’edge computing va ainsi jouer un rôle clé dans l’émergence de nouvelles applications, des villes intelligentes aux industries 4.0, en passant par les solutions de santé et de transport. »

Flexibilité, modularité et montée en puissance de l’alimentation sécurisée

Les systèmes d’alimentation sécurisée dans les datacenters doivent aujourd’hui faire face à de nouvelles contraintes importantes liées à l’évolution rapide de ces infrastructures, que ce soit pour les grands centres centralisés ou les datacenters Edge. Ces contraintes découlent de la montée en puissance des capacités informatiques, de la densité accrue des racks, et de l’extension géographique des services.

Pour Bérangère Dannely, Power Conversion Business Development de Socomec, les principaux défis rencontrés sont :

« La gestion de la haute densité énergétique :

- Densité accrue des racks : les équipements modernes ont des densités énergétiques de plus en plus élevées, avec des racks pouvant dépasser les 15 kW et parfois atteindre 30-40 kW, voire plus. Cela exige des solutions d’alimentation capables de gérer des charges électriques très concentrées.

- Pour répondre à cette demande, les systèmes UPS doivent fournir des puissances plus élevées tout en garantissant une disponibilité maximale, sans interruption.

- Les systèmes d’alimentation doivent être très efficaces pour limiter les pertes d’énergie, ce qui est essentiel pour contrôler les coûts opérationnels et réduire l’empreinte carbone.

La modularité et scalabilité :

Pour les datacenters de type hyperscale ou colocation, l’augmentation de puissance va être gérée directement au niveau des salles IT. S’il y a un besoin d’extension, l’exploitant rajoutera de nouvelles salles IT, créant de nouveaux locaux électriques associés à ces nouvelles salles. Dans ce cas, ils seront à la recherche de solutions à forte densité de puissance, déployables rapidement.

Pour les datacenters de type corporate ou Edge, l’extension se fera directement au niveau des équipements et ils seront plutôt à la recherche d’équipements modulaires ou extensibles permettant d’augmenter la puissance au fur et à mesure que le besoin augmente.

La redondance et résilience accrue :

- Tolérance aux pannes : les systèmes d’alimentation sécurisée doivent assurer une continuité de service même en cas de panne. Pour cela, les architectures N+1, 2N, redondance distribuée ou catcher (bloc redondant), permettant une redondance optimale.

- Réduction du temps d’indisponibilité dû à des opérations de maintenance : les systèmes d’alimentation sécurisée doivent proposer un haut niveau de fiabilité (MTBF) et un temps de réparation (MTTR) réduit afin de garantir le plus haut niveau de disponibilité du datacenter.

Pour répondre à tous ces défis, poursuit Bérangère Dannely, Socomec propose une gamme complète de solutions ASI pour les datacenters. Avec Delphys XM (300-800 kW) – dévoilée lors de l’édition 2024 de Data Centre World Paris – et Delphys XL (1 000-1 200 kW), nous proposons aujourd’hui deux gammes d’ASI compactes, rapides à mettre en œuvre chez nos clients colocation. Ces ASI constituées de briques de puissance permettent également de fournir un niveau élevé de résilience et un temps de maintenance réduit.

Doté d’une interface homme-machine (IHM) conviviale de 10 pouces pour une surveillance facile, d’un accès frontal complet et de modules de 100 kW remplaçables à chaud, Delphys XM minimise le temps et la complexité de la maintenance. Sa conception modulaire élimine également tout point de défaillance unique, prenant en charge la redondance N ou N+1 pour une disponibilité et une fiabilité accrues.

Pour nos clients qui souhaiteraient s’orienter vers des solutions modulaires débrochables à chaud, nos gammes Modulys GP/XM (50-600 kW) et Modulys XL (200-1 200 kW) réduisent le MTTR (temps de réparation) pour atteindre moins de 5 minutes, tout en permettant aux clients de faire évoluer leur installation au fil de leur besoin en gardant le plus haut niveau de protection (fonctionnement online).

Pour les très petites puissances, nous pouvons également intégrer l’onduleur directement dans le rack informatique, via la gamme Masterys GP4 RK de 10 à 40 kVA.

En ce qui concerne les rendements de notre offre, à ce jour, nous pouvons atteindre des rendements de l’ordre de 97 % en double conversion mais proposons également des modes de fonctionnement à haut rendement pour atteindre jusqu’à 99,1 %.

Dans le cas où une architecture de type bloc redondant serait choisie lors de la conception du datacenter, notre gamme Statys (de 32 à 1 800 A) permet également d’assurer la commutation statique entre les voies d’alimentation principales et le bloc redondant.

D’un point de vue du service, nous proposons une offre complète pour la maintenance de nos UPS. Grâce à nos contrats de maintenance incluant des services connectés (surveillance et intervention à distance notamment), nous sommes encore plus réactifs auprès de nos clients tout en réduisant le temps d’intervention. La maintenance prédictive, quant à elle, nous permet de prévoir le vieillissement des consommables et de les changer uniquement quand cela est nécessaire, ce qui a un impact positif sur l’environnement. »

Pour les environnements critiques avec des équipements informatiques à haute densité, tant dans les entreprises privées que dans les organismes publics, ainsi que dans les centres de données pour la colocation, l’hébergement en nuage et les télécommunications, ABB propose des UPS modulaires comme le MegaFlex DPA™ (IEC).

« Cette ASI (alimentation sans interruption) à haut rendement et évolutif permet une protection d’alimentation électrique en assurant le fonctionnement continu avec des gammes de puissance allant respectivement de 250 kW à 2 MW. Le MegaFlex DPA™ est notamment le plus compact du marché avec une empreinte au sol réduite jusqu’à 45 % par rapport aux modèles concurrents de puissance égale. La technologie DPA (decentralized paralleling architecture) offre une redondance totale et une tolérance aux pannes. Il en résulte une fiabilité et une disponibilité accrues du système et un système modulaire facile à faire évoluer :

- La puissance peut être optimisée pour supporter des charges variables. La disponibilité est maximisée grâce à la technologie DPA, chaque module est entièrement fonctionnel de manière indépendante, avec une redondance inhérente entre les modules ASI.

- Facilité de mise à niveau en cas de hausse de la demande énergétique.

- Facilité d’utilisation pour le personnel d’exploitation.

- Maintenance simple avec la possibilité de maintenance simultanée des modules d’alimentation pour une disponibilité en continu. Le principe de conception à module enfichable facilite et sécurise l’échange à chaud.

- Possibilité de mise en parallèle avec un maximum de quatre systèmes.

Le MegaFlex DPA™ fait partie du programme ABB EcoSolutions™ qui offre une transparence totale sur les impacts environnementaux tout au long du cycle de vie du produit. Les produits intégrant ce programme sont conformes à un ensemble d’indicateurs de performance clés définis dans le cadre de circularité d’ABB et portent une déclaration environnementale de produit externe vérifiée par un tiers (ISO 14025). »

Pour Pierre Ecuyer, directeur du Centre d’Excellence Critical Power de Legrand, l’IA et le HPC modifient profondément les architectures des datacenters, ce qui a une incidence sur les UPS. « Cela nécessite des systèmes offrant une haute densité (rapport kW/m2), une haute efficacité énergétique, supérieure à 98 % pour le système UPS dans son ensemble, une disponibilité élevée, des équipements rapides à mettre en œuvre (installation et mise en service) et une grande modularité pour coller à l’évolution des besoins.

Nos UPS offrent une modularité totale avec, au niveau des power modules, la possibilité d’adapter la puissance d’une armoire en ajoutant ou enlevant des modules, bien sûr en “Hot Swap”, sans interruption du système, la possibilité de mise en parallèle de plusieurs modules, en offrant une grande variété de raccordement (par le haut, le bas, par câble ou busbar) et en offrant une grande intensité de court-circuit.

Nous avons également une approche globale de la maintenance, visant à limiter les opérations intrusives pendant la durée de vie du produit, maîtriser le coût total de possession (TCO), anticiper les défauts éventuels, et enfin limiter les risques d’erreur humaine lors d’interventions.

Par exemple, le Keor Flex 1.2 MW embarque des algorithmes qui vont aider l’utilisateur à définir la périodicité idéale des visites de maintenance préventives et anticiper le remplacement des pièces d’usure en fonction de l’usage réel du système. Keor Flex propose également une mise à niveau automatique du firmware des power modules : une fois inséré dans le rack, le module vérifie la compatibilité avec le firmware du système et s’ajuste en conséquence. »

Pour Séverine Hanauer, les ASI doivent répondre à une accélération de la densité IT consommée dans chaque baie informatique et chaque salle complète avec des équipements IT plus puissants dans un même encombrement, mais aussi à une hausse considérable des fluctuations des consommations électriques liées à cette augmentation de l’échelle de consommation et à l’intégration de sources d’énergies renouvelables sur le réseau électrique.

« Dans ce sens, les ASI actuelles doivent être compactes et correctement dimensionnées, pour limiter les investissements financiers dans les surfaces techniques à prévoir. Il faut aussi qu’elles acceptent de plus gros impacts potentiels de charge. De même, tout le réseau d’alimentation électrique du site doit être adapté à ces nouvelles fluctuations.

La nouvelle gamme d’ASI Vertiv™ Trinergy™ a été conçue afin d’optimiser la consommation électrique dans les datacenters, améliorant de manière significative l’efficacité énergétique tout en réduisant les coûts d’exploitation. C’est une solution intégrée qui associe performance et faible encombrement, permet d’économiser 30 % de surface au sol et offre un rendement en double conversion exceptionnel jusqu’à 97,1 % ou 99 % avec le mode Dynamic Online. Ce taux de rendement supérieur réduit le gaspillage d’énergie et les besoins en refroidissement. Cela permet la diminution de la consommation électrique globale et des coûts d’exploitation des datacenters, tout en garantissant que les opérations critiques sont protégées en permanence par une alimentation fiable et ininterrompue.

Le Vertiv Trinergy est également équipé de boosters à service continu et de commutateurs bypass statiques, permettant une alimentation sans interruption, même à pleine charge. Le système ASI prend en charge des fonctionnalités de partage d’alimentation continue à travers différentes sources d’énergie, ce qui permet une gestion flexible de l’alimentation de secours et l’intégration avec des sources d’énergie distribuées, y compris des micro-réseaux. Ces caractéristiques font de Vertiv Trinergy non seulement une solution extrêmement fiable mais aussi innovante, prête à s’adapter aux besoins énergétiques émergents et aux demandes futures.

Vertiv Trinergy se distingue par sa conception avancée et sa flexibilité inégalée. L’une de ses principales caractéristiques est l’intégration transparente avec diverses sources d’énergie, y compris les batteries lithium-ion et nickel-zinc, lui permettant d’offrir une alimentation de secours adaptable et personnalisée à une variété de besoins opérationnels. De plus, les fonctionnalités de partage d’alimentation continue de Vertiv Trinergy à travers plusieurs sources d’énergie permettent une gestion d’alimentation fiable, même pendant les charges variables. Cette fonctionnalité est entièrement optimisée pour l’intégration avec un appareillage électrique sur skids et des modules d’alimentation, offrant un niveau supérieur de flexibilité pour la gestion de l’alimentation secourue.

Le Vertiv Trinergy est également conçu pour optimiser les performances des applications à haute densité. Sa puissance de sortie supérieure le rend particulièrement adapté aux environnements d’IA et de calcul à haute performance (HPC), qui nécessitent d’importantes ressources en énergie. De plus, Vertiv Trinergy est une plateforme globale et résiliente qui assure une disponibilité continue de l’énergie et une intégration fluide avec les systèmes du réseau d’alimentation et les appareillages électriques. Cela en fait une solution idéale pour les opérations à grande échelle qui recherchent une protection électrique fiable et orientée vers l’avenir ».

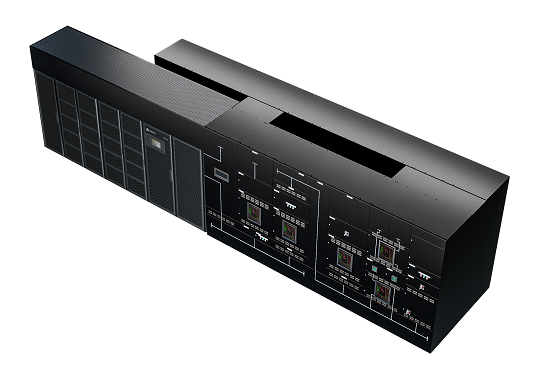

Vertiv Trinergy peut aussi être associé à un tableau de distribution fiable, Vertiv PowerNexus conçu pour former un bloc unique sur le site du client pour optimiser l’espace, l’installation et les délais de mise en service. « Vertiv™ PowerNexus combine la puissance supérieure de VertivTM Trinergy™ et l’appareillage électrique Vertiv™ PowerBoard dans un bloc unique, qui est relié par des jeux de barres internes, réduisant ainsi l’encombrement des équipements, les matériels de câblage et les coûts de main-d’œuvre d’installation. Il s’agit d’une solution d’alimentation qui fusionne de manière transparente la protection de la charge et la distribution électrique. Cette architecture d’alimentation deux en un permet aux opérateurs de datacenters d’utiliser un espace précieux, de réduire les matériels de câblage et les coûts de main-d’œuvre d’installation. »

Les baies informatiques doivent aussi s’adapter à cette montée en puissance (et en poids)

Les baies informatiques doivent s’adapter pour accueillir des équipements plus lourds et plus denses associés à l’IA, ce qui suppose des baies plus robustes avec plus d’espace et une meilleure gestion des câbles d’alimentation.

Pour répondre à ces contraintes, mais aussi aux exigences réglementaires de la directive européenne sur l’efficacité énergétique (EED), Schneider Electric vient de présenter une nouvelle gamme d’armoires White Space, NetShelter SX Gen2.

« Nos armoires NetShelter SX Gen2 constituent un pas en avant pour répondre aux exigences critiques des applications à haute densité, a expliqué Philippe Carle, responsable marketing France des offres Schneider Electric Edge computing Secure Power. Grâce à une masse admissible des équipements supérieure, à la gestion des flux d’air et à la sécurité physique, nous permettons à nos clients d’optimiser les opérations de leurs centres de données tout en favorisant le développement durable.

Le dernier système de confinement thermique NetShelter peut permettre d’atteindre jusqu’à 20 % de capacité de refroidissement en plus. C’est crucial pour gérer la chaleur générée par les serveurs IA et les autres applications à haute densité. Le système intègre un régulateur de flux d’air réduisant ainsi jusqu’à 40 % la consommation d’énergie par rapport aux systèmes de refroidissement passifs traditionnels.

Le confinement reste primordial dans les datacenters à haute densité d’aujourd’hui, ajoute Philippe Carle. Même dans les applications intégrant du liquid cooling, la gestion des flux d’air est essentielle. Nos solutions de confinement thermique NetShelter améliorent non seulement la capacité de refroidissement, mais garantissent également des économies d’énergie significatives, conformément à notre engagement en faveur du développement durable. »

Des datacenters modulaires pour faciliter le déploiement de l’IA

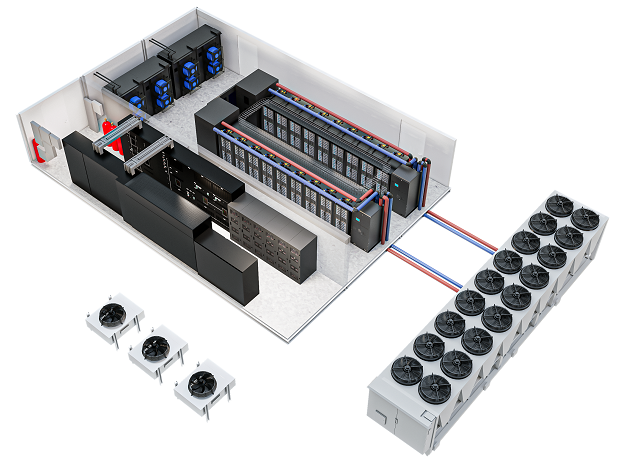

Pour répondre à une demande d’infrastructures évolutives, flexibles et optimisées pour des secteurs aussi divers que l’industrie 4.0, la santé connectée, le commerce (retail) ou le véhicule autonome, les datacenters modulaires sont de plus en plus proposés par les constructeurs.

Séverine Hanauer, de Vertiv, explique : « Portés par les avancées de l’IA, de l’edge computing et de l’Internet des objets (IoT), les datacenters modulaires se sont imposés comme un élément essentiel à la réussite des opérations de nombreuses entreprises. La dépendance croissante à l’égard de l’informatique a mis en évidence les limites des datacenters classiques construits sur mesure. Ces inconvénients comprennent le manque de flexibilité ou évolutivité, l’inefficacité due au surdimensionnement et les coûts élevés associés aux travaux sur site.

La demande en alimentation électrique secourue, en options de refroidissement flexibles et en puissance informatique immédiatement disponible a évolué. Un datacenter traditionnel peut ne plus être suffisamment dimensionné pour répondre demain à une nouvelle demande de traitement de données et souligne l’importance et la pertinence des datacenters modulaires capables de répondre plus rapidement aux besoins dynamiques des entreprises. Les entreprises peuvent considérer les solutions modulaires préfabriquées (PFM) comme des options plus appropriées face à ces défis.

Selon la dernière étude d’Omdia, la demande de solutions modulaires préfabriquées et de micro datacenters a été accélérée par l’IA. Les ingénieurs de Vertiv ont appliqué des apprentissages fructueux autour des solutions préfabriquées et les besoins des déploiements d’IA au développement des solutions Vertiv™ MegaMod™ CoolChip, afin de supporter les exigences de l’IA d’aujourd’hui – et de demain.

La solution Vertiv™ MegaMod™ CoolChip intègre les meilleures technologies de sa catégorie, notamment le refroidissement liquide à haute densité, pour fournir une infrastructure critique pour l’IA clé en main jusqu’à 50 % plus rapide que la construction sur site.

C’est une solution de datacenter modulaire préfabriqué (PFM) équipée d’un système de refroidissement liquide, conçue pour permettre l’efficacité et la fiabilité du AI computing. Elle peut être configurée pour prendre en charge les plateformes des principaux fournisseurs de calcul IA et évoluer en fonction des besoins du client. En réunissant la qualité et l’efficacité des processus, permises par la fabrication hors site et avec les meilleures technologies prêtes pour l’IA, le MegaMod™ CoolChip peut réduire jusqu’à 50 % le temps de déploiement de l’infrastructure numérique critique de l’IA.

Il s’agit d’une solution clé en main qui intègre la technologie Vertiv™ CoolChip pour prendre en charge le refroidissement liquide direct-to-chip, la protection et la distribution électrique à haute efficacité, ainsi que d’autres technologies d’infrastructure numérique critique. La solution peut être utilisée comme une rénovation modulaire d’une installation existante ou comme un nouveau datacenter autonome, supportant jusqu’à plusieurs centaines de kilowatts par rangée et jusqu’à plusieurs mégawatts avec des unités préfabriquées. »

L’importance de solutions DCIM performantes et adaptées à ces nouveaux besoins

La convergence de l’infrastructure informatique, de l’IA et de la durabilité représente un défi complexe pour les organisations. Les centres de données, épine dorsale de l’informatique moderne, sont d’importants consommateurs d’énergie. De plus, l’augmentation rapide du domaine de l’IA augment encore la demande d’énergie. Cette convergence de facteurs nécessite des solutions innovantes pour minimiser l’impact environnemental. Dans cette quête de durabilité, la gestion de l’infrastructure apparaît comme un outil essentiel. Le logiciel DCIM est utilisé pour surveiller, mesurer et gérer les centres de données, couvrant à la fois les équipements informatiques et les infrastructures de support telles que les systèmes d’alimentation et de refroidissement. Il vise à aider les gestionnaires à atteindre une efficacité énergétique maximale et à prévenir les problèmes d’équipement qui entraînent des temps d’arrêt.

« Les solutions DCIM (Data Center Infrastructure Management) performantes jouent un rôle crucial dans la gestion des nouveaux sites en fournissant une suite complète d’outils pour surveiller, gérer et optimiser l’infrastructure informatique et les équipements associés, avec quelques points-clés, comme le souligne Alfred Francis, Territory Sales Representative chez Schneider Electric :

- Surveillance en temps réel : les solutions DCIM offrent une surveillance en temps réel de l’infrastructure, permettant une détection rapide des problèmes et une réponse proactive pour minimiser les temps d’arrêt.

- Gestion de l’énergie : elles permettent de surveiller et de gérer efficacement la consommation d’énergie, contribuant à des opérations plus durables et rentables.

- Optimisation de l’espace : en fournissant une vue détaillée de l’emplacement et de l’utilisation de l’espace, les solutions DCIM aident à optimiser l’agencement des équipements pour une utilisation efficace de l’espace disponible.

- Planification de capacité : elles offrent des outils pour planifier de manière précise la capacité future, permettant ainsi une croissance maîtrisée et évitant les surcharges inattendues.

- Visibilité complète : grâce à des tableaux de bord et des rapports détaillés, les solutions DCIM offrent une visibilité complète sur l’ensemble de l’infrastructure, ce qui facilite la prise de décision informée et la gestion proactive des opérations.

Les solutions DCIM sont essentielles pour assurer la disponibilité, l’efficacité et la fiabilité des opérations dans les nouveaux sites, tout en contribuant à une utilisation optimale des ressources et à des performances améliorées. »

L’IA crée des opportunités techniques, commerciales et scientifiques pour déployer et développer de nouvelles capacités et outils. Néanmoins, cela crée également des défis quant à la façon de déployer rapidement les infrastructures des centres de données requis et adaptés, mais la dynamique est lancée pour renforcer la résilience et les capacités de ces sites.

Jean-Paul Beaudet