Un refroidissement adapté et efficace est un élément-clé de la performance d’un datacenter, petit ou grand, en termes de disponibilité et de coût de fonctionnement. Un coût qui représente encore souvent de 40 à 50 % des dépenses d’énergie du centre informatique, très loin devant la distribution électrique sécurisée ou l’éclairage. De nouvelles solutions arrivent sur le marché pour diminuer fortement cette consommation d’électricité, tout en apportant une réponse à l’évolution des salles informatiques (modularité, gestion sophistiquée, augmentation de la puissance des baies).

Les opérateurs et exploitants de datacenters ont entrepris depuis 10 à 15 ans des opérations de réduction de leurs coûts de mise en œuvre (OPEX), mais aussi de fonctionnement sous la pression de la hausse du coût de l’électricité, de la concurrence de sites installés dans des pays à bas coûts d’énergie ou possédant une production basée sur les énergies renouvelables (comme l’Islande, le Danemark ou la Norvège). Sans oublier la pression de la réglementation (Code de conduite des datacenters en Europe) ou l’importance de la responsabilité sociétale liée aux émissions de gaz à effet de serre. Dans le même temps, les datacenters doivent traiter, stocker, sécuriser et restituer les données 24 h/24 et 7 j/7 ; des données de plus en plus nombreuses et qui devraient exploser avec l’Internet of Everything (IoE). Cela va nécessiter des datacenters de tailles très variables, allant des méga-datacenters, du cloud, à la colocation de petits datacenters de proximité, en passant par le Edge. [voir j3e n° 860 de mars 2018].

Tous ces datacenters devront être conçus de manière écoresponsable, intégrés dans l’écosystème de leur site. Les spécialistes parlent de datacenters de 4e génération dotés d’une efficacité, d’une disponibilité et d’une évolutivité accrues, avec des architectures modulaires, évolutives et standardisées pour faciliter leur exploitation et leur sécurité.

Le refroidissement, élément-clé de la performance du datacenter

Le refroidissement représente encore souvent plus de 40 à 50 % des dépenses d’énergie d’un centre informatique, parfois plus pour ceux qui ont été construits au début des années 2000. C’est un élément-clé de sa performance, de son coût d’exploitation et de sa disponibilité : un arrêt de son refroidissement entraîne très rapidement l’arrêt du site.

« On ne le répétera jamais assez : les performances d’un datacenter dépendent principalement de sa conception et de son environnement, explique François Salomon, responsable du développement de l’offre Froid/Climatisation de Schneider Electric France. Il est en particulier essentiel d’urbaniser la salle informatique en structurant les rangées de racks informatiques en allées froides et en allées chaudes confinées. En séparant ainsi les flux d’air chaud et les flux d’air froid, il est possible de gagner 7 à 8° sur la température d’exploitation des locaux et donc de faire des économies substantielles. »

Le confinement des allées chaudes est la solution préférée pour les nouvelles installations ou pour les rénovations de salles avec faux plancher, mais peut être plus délicate dans certaines configurations de rénovation. Si le confinement de l’air chaud permet des économies plus importantes par rapport à un refroidissement de salle traditionnel, les deux systèmes permettent d’augmenter les capacités de refroidissement avec des températures de fonctionnement sécurisées et plus élevées, une élimination des zones de surchauffe et, au final, un nombre d’heures de fonctionnement en free cooling plus important.

L’utilisation du free cooling se généralise

La tendance est très nettement au free cooling, c’est-à-dire à l’utilisation de sources de froid gratuites pour refroidir le datacenter ; en général un free cooling air/air direct ou indirect avec un échangeur de chaleur.

Pour Séverine Hanauer, Data Center & Telecom Sales Director & Consulting & Solutions Director de Vertiv France, « l’utilisation du free cooling dans les technologies de refroidissement des datacenters, grands, moyens ou petits est en plein développement et permet notamment de limiter la consommation de réfrigérants et de réduire la facture de la consommation électrique. Différents types de technologie en free cooling existent aujourd’hui, avec des architectures très distinctes et permettent ainsi de répondre aux contraintes des sites. Pour la rénovation d’anciens datacenters, les technologies en free cooling améliorent toujours l’efficacité énergétique du moment que les paramètres de températures dans les salles et/ou de températures du réseau d’eau glacée sont augmentés. Le gain en pourcentage peut aller jusqu’à environ 35 % en fonction des caractéristiques du site à l’origine et de l’architecture du système de climatisation qu’il est possible, physiquement, de mettre en œuvre. Mais certaines architectures de refroidissement sont plus difficiles, voire impossibles à mettre en œuvre sur des sites existants, car il est impératif que l’architecture du bâtiment existant et la distribution des salles et des couloirs de baies informatiques en interne se prêtent à ces changements de technologie ».

En fonction de tous ces paramètres, le climaticien va pouvoir concevoir l’architecture de son système de production de froid adapté au process qu’il devra refroidir.

Damien Giroud, directeur Datacenter Solutions de Schneider Electric France, le note : « plus de 80 % des projets de refroidissement se font aujourd’hui en free cooling, le surcoût de l’investissement par rapport à une solution traditionnelle avec compresseur est faible et le retour sur investissement de cet écart de coût est aujourd’hui de 1,5 à 2 ans. Mais les gains sur les rendements des équipements viennent aussi de l’augmentation des régimes d’eau glacée permettant des températures d’évaporation plus élevées. On est ainsi passé de régimes d’eau glacée à 7-8 °C à un refroidissement avec une eau tiède à 20-30 ° pour maintenir des températures jusqu’à 27° à l’aspiration des serveurs pour suivre les recommandations de l’ASHRAE. En moyenne, une augmentation de 1° de la température en sortie du groupe froid entraîne une augmentation de 3 % de la puissance du groupe d’eau glacée. Il a fallu développer des équipements pour ces températures plus élevées, mais les gains se font sur tous les matériels, y compris les pompes ou les tuyaux d’eau. Ces gains se font aussi dans les refroidissements par rangées (InRow) : en quelques années, on est passé dans la même largeur de 300 mm de puissances de 15-20 kW à 30-40 kW ». L’évolution vers des architectures à haute température a nécessité de repenser les technologies et les gammes de produits pour bénéficier pleinement de cette élévation, mais aussi, selon Séverine Hanauer, « pour adapter les solutions aux conditions/exigences du site : climat, architecture du bâtiment, densité dans les baies, température tolérée dans les salles IT ».

Cela peut passer par de nouvelles régulations, des échangeurs de chaleur redimensionnés ou de nouveaux fluides réfrigérants. Parmi les nouvelles solutions pour encore améliorer l’efficacité du free cooling indirect air/air il y a le refroidissement adiabatique et évaporatif.

Élargir les plages de fonctionnement en free cooling grâce au froid adiabatique

Damien Giroud explique : « Il s’agit d’un procédé de refroidissement local de l’air effectué grâce à la pulvérisation d’eau sous la forme de fines gouttelettes qui s’évaporent. Physiquement, l’eau qui s’évapore absorbe une grande quantité d’énergie (chaleur latente) qu’elle prend à l’air “chaud”, qui se refroidit donc localement. Pour ce faire, il est nécessaire :

> De créer une grande surface d’échange air/eau, d’où la pulvérisation de l’eau ;

> De forcer l’échange air/eau (convection), d’où la mise en place de ventilation.

Notre nouvelle solution de free cooling indirect air/air Ecoflair utilise cette technologie avec un échangeur de chaleur en polymère pour mieux résister à la corrosion, un échangeur modulaire pour le rendre facilement remplaçable. Ecoflair est disponible en modules de 250 et 500 kW et peut s’installer au sol ou en toiture. »

Un système de refroidissement évaporatif que propose Vertiv avec ses solutions Liebert® AFC, un groupe d’eau glacée de type free cooling intégré, avec des panneaux adiabatiques humides permettant d’abaisser de 5 à 10° la température de l’air rentrant dans l’échangeur et Liebert® EFC pour un free cooling indirect à air avec échangeur évaporatif à eau pulvérisée. Le groupe Liebert® EFC a été conçu pour modifier automatiquement son mode de fonctionnement en fonction de l’environnement extérieur, afin d’optimiser l’efficacité globale du système. Dans les climats à taux d’humidité élevé, l’unité peut nécessiter l’intégration d’un système à détente directe (DX).

La hausse des températures dans les datacenters ne permet plus d’opérer les équipements de manière approximative : des solutions de régulation et de contrôle sont proposées par les constructeurs. Le logiciel Vertiv™ ICOM™ est intégré et assure la régulation et le contrôle dans tous les modèles d’armoires de climatisation, les groupes de production d’eau glacée et les systèmes de refroidissement adiabatique évaporatif de Vertiv et le logiciel Supersaver permet un dialogue entre les armoires de climatisation et groupes de production d’eau glacée Vertiv : en fonction du niveau de charge dans les salles informatiques, les climatiseurs renvoient des informations aux groupes de production d’eau glacée avec pour objectif de diminuer leur consommation électrique dès que l’on est à un niveau de charge partielle.

Pour Damien Giroud, « une solution comme OMI (Optimized Management Interface) permet une gestion dynamique du point de consigne en eau glacée en fonction de la charge : la production frigorifique fonctionne sur le régime d’eau le plus élevé. Pour les refroidissements InRow, AFC (Active Flow Control) fait un contrôle mutualisé du débit d’air pour maintenir une pression différentielle confinement/ambiance constante et adapter le débit d’air à la charge informatique ».

L’importance du DCIM

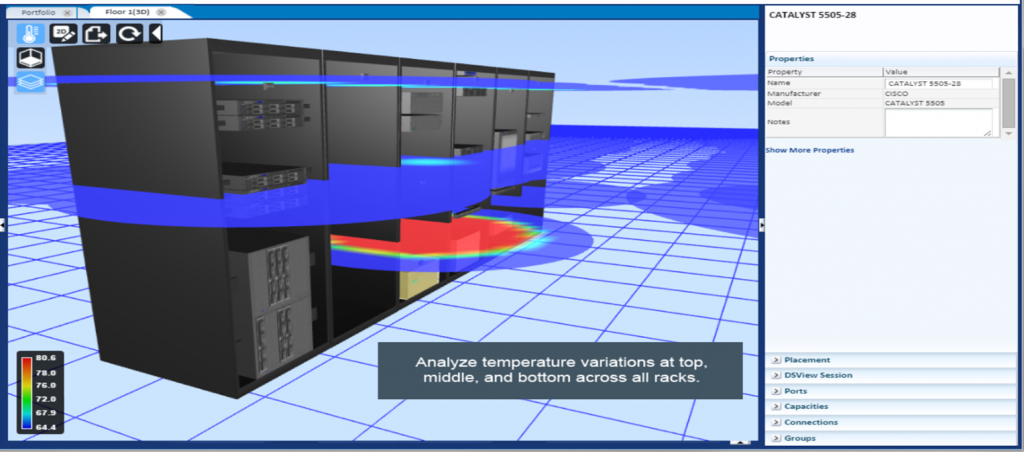

Les logiciels de DCIM vont aussi permettre une gestion centralisée de l’infrastructure physique à partir de centaines de points de données qui communiquent sur la disponibilité, la température, le flux d’air, l’humidité ou la sécurité. Trellis™ de Vertiv intègre ainsi un module spécifique, Trellis Thermal Management, permettant à l’exploitant d’anticiper, de corriger et donc d’optimiser la gestion de son datacenter.

Pour Schneider Electric, la gestion centralisée de l’infrastructure physique se fait à partir d’Ecostruxure for Data Centers, EcoStruxure™ étant l’architecture et la plateforme de système ouverte, interopérable et compatible IoT (Internet des Objets) de Schneider Electric.

Des solutions modulaires

À mesure qu’un centre de données se développe, il importe que son architecture de refroidissement soit capable d’accompagner cette évolution, plutôt que d’être initialement démesurée en vue du cas le plus défavorable d’une charge finale inconnue du centre de données. La possibilité de déployer la capacité dans le temps contribue à la gestion des frais d’exploitation et des investissements. Un concept modulaire permet d’adapter la capacité aux besoins, sans interrompre la charge informatique ni le système installé.

Pour Séverine Hanauer, « elles présentent un gain de temps, lors de chaque besoin d’extension. Elles permettent aussi d’échelonner les investissements sur le datacenter et d’être davantage flexible quand arrive un nouveau client avec une demande personnalisée ». Même si dans un datacenter la taille de la brique de base ne sera pas la même pour les transformateurs, les onduleurs ou les climatiseurs. Pour Martine Parent, chargée d’affaires de Modulo C, « les solutions de refroidissement en conteneur se font en général dans la rangée en détente directe ou eau glacée. Les climatisations sont intelligentes afin de gérer le free cooling en fonction de la température et de repasser en détente directe si besoin. Car les besoins en puissance peuvent être très variés entre les baies d’une PME de 5-6 kW et des applications de calcul scientifique ou de machine learning beaucoup plus gourmandes en énergie, mais qui ne demandent pas toujours de redondance de climatisation ».

Pour répondre aux besoins en rapidité et flexibilité des déploiements informatiques, Schneider Electric vient de lancer sa solution HyperPod™ qui préintègre la distribution électrique, le refroidissement, l’alimentation et la gestion logicielle par incrément de 8 à 12 racks. HyperPod™ peut être déployé en tant que module unique ou au sein de configurations plus étendues.

Et si on refroidissait autrement ?

Si on remplaçait l’air ou l’eau du refroidissement par de l’huile (ou un liquide spécial) dans laquelle on plongerait les serveurs et autres équipements informatiques pour ensuite récupérer la chaleur dissipée par ces équipements ? C’est la solution que propose Immersion4™ : des « tanks » remplis d’une huile spéciale dans laquelle baignent tous les équipements, câbles et connecteurs. Pour Serge Conesa, fondateur et CEO d’Immersion4, « notre solution permet de récupérer l’énergie des équipements d’un datacenter et de la convertir en énergie stable et renouvelable facilement utilisable. Les serveurs sont immergés dans un fluide diélectrique qui dissipe la chaleur 1500 fois mieux que l’air : plus de poussières, d’humidité ou d’oxydation ; la température des serveurs est maintenue à 37°. L’énergie est valorisée via un récupérateur ou une pompe à chaleur. Les coûts de refroidissement sont réduits de plus de 90 % et le gain de place est très important ». Une solution que Martine Parent verrait bien installée dans ses modules pour des entreprises ayant besoin de beaucoup de puissance pour leurs calculs (CEA, CNRS,…).

Jean-Paul Beaudet