Pour la conception et l’installation de la salle informatique de son nouveau siège en France hébergeant son système d’information et ses applications métiers, SAP France a choisi des solutions performantes et innovantes. Mais les contraintes de ce projet étaient importantes : délai très court nécessitant une coordination sans faille, implantation dans un IGH en rénovation complète et objectifs environnementaux ambitieux. Un pari tenu avec un datacenter livré clés en main en six mois et opérationnel le jour J, et la mise en œuvre de solutions nouvelles bien adaptées au cahier des charges de SAP.

Basé à Walldorf en Allemagne et avec des bureaux dans plus de 130 pays, SAP SE est leader sur le marché des logiciels et applications d’entreprise. En 2013, SAP France, qui supervise les opérations de SAP SE en France et au Maghreb, décide de consolider ses activités sur un seul et même site à Levallois-Perret, en proche banlieue parisienne, dans une tour de 22 étages en rénovation complète et de regrouper en une salle serveurs les équipements de 8 salles informatiques.

Des contraintes environnementales et techniques importantes

L’objectif est de créer une salle de serveurs de 80 m2 au centre de la tour au 14e étage de ce nouveau siège et 17 locaux techniques sécurisés à chaque étage pour la distribution horizontale de chaque plateau. Pour Joseph Cinquanta, IT Account Manager de SAP France en charge du projet, « SAP poursuit ses efforts pour devenir un modèle d’entreprise écologique compatible avec les standards internationaux de l’économie durable. SAP s’est engagé à améliorer en permanence ses performances économiques et environnementales telles que la réduction de ses émissions de carbone pour revenir au taux des années 2000 d’ici les cinq prochaines années : le datacenter doit être peu énergivore pour respecter cette politique environnementale détaillée dans la partie « Energy and Emissions » de l’ »Integrated Report 2014″ de SAP ».

Les contraintes du projet sont aussi techniques pour cette implantation dans un IGH (immeuble de grande hauteur) : création d’une colonne d’eau glacée, contraintes de charge au sol faible et de percement des planchers, création de la salle serveurs au centre de la tour. Mais pour Joseph Cinquanta la contrainte la plus importante était le délai très court : « Premières réunions et consultations fin 2013 pour rendre tout cela opérationnel pour l’arrivée des 400 premiers collaborateurs en juillet 2014. L’expérience de déménagements antérieurs et de retards nous a convaincus de traiter avec une seule entreprise pour l’ensemble des infrastructures énergétiques, le refroidissement, la distribution électrique, le faux plancher, l’urbanisation de la salle et le logiciel de DCIM avec le suivi et la coordination du chantier. » Mais, ajoute Florian Tillmann, IT EMEA INT Build Outs de SAP, « il était également important d’avoir un seul interlocuteur pour la maintenance : un seul appel à passer avec un interlocuteur qui connaît le site, les contraintes, les matériels ».

SAP a retenu l’offre technique de Schneider Electric qu’il avait déjà utilisée dans d’autres pays. Pour Damien Giroud, responsable Datacenter ITB France de Schneider Electric, « cette solution du siège SAP est modulaire et pourra se décliner pour d’autres sites dans le monde, toutes les infrastructures de SAP étant pratiquement identiques à 80 % ».

Des solutions techniques innovantes et modulaires

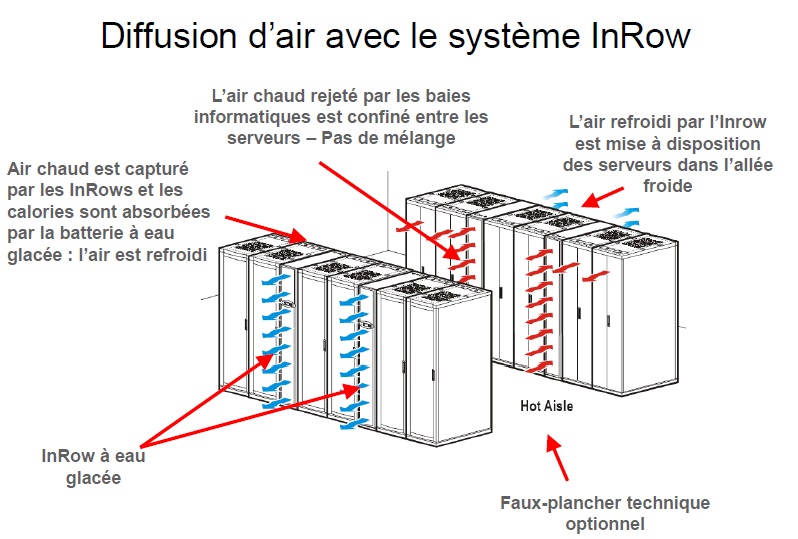

La configuration installée se compose de 18 armoires rack NetShelter SX dans la salle serveurs et 34 armoires dans les locaux techniques à chaque étage. Les baies de la salle serveurs sont installées avec un confinement d’allée chaude et un refroidissement par rangée (InRow). Ce refroidissement InRow de nouvelle génération réservé aux installations avec régime d’eau glacée élevé a une capacité frigorifique jusqu’à 60 kW et de hautes performances énergétiques. Ces unités de faible largeur (300 mm) sont intégrées dans le cube informatique au plus près de la source de chaleur. Et pour une maintenance simplifiée les ventilateurs sont remplaçables « à chaud » et un contrôle du point de rosée évite d’avoir un bac de condensats. Mais pour Damien Giroud le point fort de ces climatiseurs InRow est leur AFC (Active Flow Control) : « Le débit d’air des InRow se fait par contrôle de pression dans le confinement et confirme que les serveurs sont à la bonne température : le système garantit l’équilibre entre le débit d’air délivré par les InRow et le débit d’air aspiré par les serveurs, d’où une réduction de la consommation énergétique liée à la ventilation, et l’InRow reprend l’air le plus chaud possible et augmente son rendement ». Les serveurs travaillent ainsi dans les meilleures conditions avec la ventilation juste nécessaire.

Le site est également équipé d’une gestion globale et dynamique de l’installation de production frigorifique dite OMI (Optimized Management Interface) avec gestion dynamique du point de consigne des groupes frigorifiques en fonction de la charge et des conditions environnementales pour augmenter le COP des groupes et le temps de fonctionnement en free-cooling. Pour cela ces groupes frigorifiques et les unités terminales sont interconnectés, cette communication fait un état des lieux permanent et adapte le point de consigne en eau glacée. Et Joseph Cinquanta de conclure : « On a une salle intelligente et sa maintenance est plus IT que services généraux ».

Des onduleurs, batteries et armoires de distribution modulaires

SAP a choisi des onduleurs modulaires pour pouvoir s’adapter à l’évolution des besoins : les onduleurs Symmetra PX 160 et PX 96 sont constitués de modules 16 kW avec redondance N+1. La conception modulaire permet une réparation rapide avec des modules à autodiagnostic remplaçables sur place. Les batteries sont également installées en armoires sous forme de modules facilement débrochables et démontables sans risques « à chaud ». « Une batterie peut être changée sans arrêter la salle. »

Pour la distribution électrique, le choix de SAP s’est porté sur des armoires dites PDPM. Ces tableaux qui font 1/2 rack de 300 mm de large peuvent contenir jusqu’à 18 disjoncteurs triphasés différentiels. L’intérêt pour Franck Laporte, ingénieur commercial Datacenter de Schneider Electric, qui a suivi le projet est « qu’il est possible de connecter/déconnecter à chaud (sous tension) des disjoncteurs précâblés sans outil et sans habilitation électrique du technicien, de monitorer l’installation avec des seuils d’alarme sur la puissance de chaque disjoncteur. Des interfaces d’administration en réseau permettent une gestion par navigateur Web et protocoles SNMP et Telnet ». Florian Tillmann explique que « dans chaque rack il y a deux PDU (Power Distribution Unit), l’une est alimentée par EDF et l’autre par l’onduleur pour les serveurs et locaux techniques avec des reports de consommation pour chaque disjoncteur ». Toutes ces informations sont bien entendu gérées par une application DCIM (Data Center Infrastructure Management) StruxureWare Datacenter Expert et Datacenter Operation qui donne un aperçu du fonctionnement de la salle avec le monitoring et le reporting (montée en température, coupure de courant…). En cas de problème un mail peut être envoyé aux personnes listées. Pour Joseph Cinquanta, « cette partie monitoring est importante, pour connaître par exemple l’âge des batteries ou avoir le monitoring des températures : on peut tout personnaliser comme les vitesses de ventilation des climatiseurs ou détecter un problème dans une salle en travaux ».

Une installation des groupes froid délicate

La partie la plus délicate du chantier était l’installation des deux groupes froid de 300 kW de plus de 4 tonnes sur la terrasse du 22e étage, un véritable challenge pour l’entreprise Dumez, le maître d’œuvre et l’équipe de Schneider Electric. La solution a été de faire appel à un hélicoptère Super Puma, mais le poids de ces climatiseurs dépassait la charge limite de cet hélicoptère. La solution, pour Olivier Delépine, vice-président IT Business de Schneider Electric IT France, a été « de démonter une partie de ces groupes froid après leur test en usine en Italie, de les remonter sur le toit et de les re-tester de nouveau pour garantir leurs performances ». Une installation minutée qui devait se faire dans un temps très court de 20 à 30 mn du fait des contraintes de vol en région parisienne et une pose au millimètre près sur un toit déjà bien occupé par des équipements et gaines.

Au final, une installation mise en service dans des délais très courts avec une bonne coordination de tous les acteurs et répondant aux attentes des utilisateurs avec une bonne performance énergétique validée par un PUE de 1,3.

Joseph Cinquanta souligne que « en 15 ans de métier et 8 déménagements, c’est la première fois que je vois une solution opérationnelle le jour J avec un timing aussi serré. L’approche « All in one » présente indiscutablement des avantages ». Chez Schneider Electric on salue la coopération entre les différents services de SAP. « La forte implication de la DSI de SAP aux côtés de l’installateur tout au long du projet a permis la création en un temps record d’une salle informatique de pointe en terme d’efficacité énergétique et de disponibilité », déclare Franck Laporte.

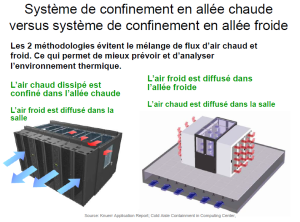

Confinement allée chaude ou allée froide ?

Le confinement allée chaude ou allée froide de l’air sortant ou entrant dans les baies de serveurs est de plus en plus utilisé car il apporte de nombreux avantages :

- la fiabilité sera accrue avec moins de points chauds en évitant le mélange de l’air froid et de l’air chaud ;

- la densité de puissance par baie peut être augmentée en éliminant la recirculation d’air chaud. La capacité de refroidissement est accrue avec une augmentation de la différence de température entre l’air entrant et l’air sortant ;

- les coûts d’humidification ou de déshumidifacation sont réduits en éliminant ce mélange air chaud/air froid et en augmentant la température de l’air entrant.

Dans le confinement des allées froides, l’air froid produit dans les unités de refroidissement périphériques est envoyé par le faux plancher, l’air chaud étant libre dans la salle. Le déploiement de ce confinement est souvent réalisé en fermant les extrémités des allées froides (rideaux ou portes).

Un système de confinement des allées chaudes entoure l’allée chaude à l’arrière des baies pour recueillir l’air chaud évacué des équipements informatiques, l’air froid étant diffusé dans la salle. Comme dans le cas de SAP, ce système de confinement de l’allée chaude fonctionne comme une zone indépendante. L’efficacité du confinement de l’allée chaude est supérieure, l’allée chaude étant à même de maintenir des températures plus élevées (jusqu’à 38°) pour l’air de retour aux unités de refroidissement, d’où un meilleur rendement global. Ce type de confinement permet de mieux tirer parti du free cooling. Le confinement de l’allée chaude est considéré comme une approche plus efficace du refroidissement d’une salle nouvelle.